Apple heeft compacte OpenELM-taalmodellen vrijgegeven voor gebruik op gadgets

Mohamed M/Unsplash

Apple heeft lichtgewicht OpenELM-taalmodellen onthuld die lokaal op apparaten kunnen draaien zonder cloudverbinding.

Dit is wat we weten

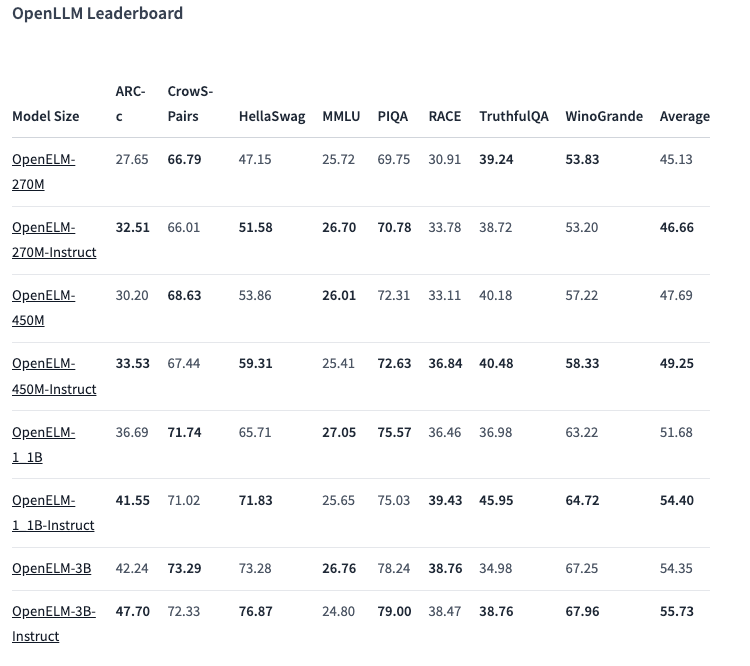

Er zijn acht modellen van twee types in de OpenELM line-up - voorgetraind en aangepast per instructie. Elke variant is beschikbaar met 270 miljoen, 450 miljoen, 1,1 miljard en 3 miljard parameters.

De modellen zijn voorgetraind op openbare datasets van 1,8 biljoen tokens van sites als Reddit, Wikipedia, arXiv.org en andere.

Dankzij optimalisaties kan OpenELMs functioneren op gewone laptops en zelfs op sommige smartphones. De tests werden uitgevoerd op pc's met Intel i9 en RTX 4090 en op MacBook Pro M2 Max.

Volgens Apple laten de modellen goede prestaties zien. Vooral de 450 miljoen parameter variant met instructies springt eruit. En OpenELM-1.1B presteerde 2,36% beter dan zijn GPT tegenhanger OLMo, terwijl het de helft minder tokens nodig had voor pre-training.

In de ARC-C benchmark, ontworpen om kennis en redeneervaardigheden te testen, toonde de voorgetrainde OpenELM-3B variant een nauwkeurigheid van 42,24%. Daarentegen scoorde het 26,76 % en 73,28 % op respectievelijk MMLU en HellaSwag.

Het bedrijf heeft de OpenELM broncode op Hugging Face gepubliceerd onder een open licentie, inclusief getrainde versies, benchmarks en modelinstructies.

Apple waarschuwt echter dat OpenELM's onjuiste, schadelijke of ongepaste reacties kunnen produceren door een gebrek aan veiligheidswaarborgen.

Bron: VentureBeat