Neues Nightshade-Tool ermöglicht es Künstlern, Daten für das KI-Training heimlich zu verfälschen

Universität von Chicago

Ein Team der University of Chicago hat ein Tool namens Nightshade entwickelt, mit dem Künstler unsichtbare Pixel zu ihren Werken hinzufügen können, die die Trainingsdaten für die KI verderben.

Was bekannt ist

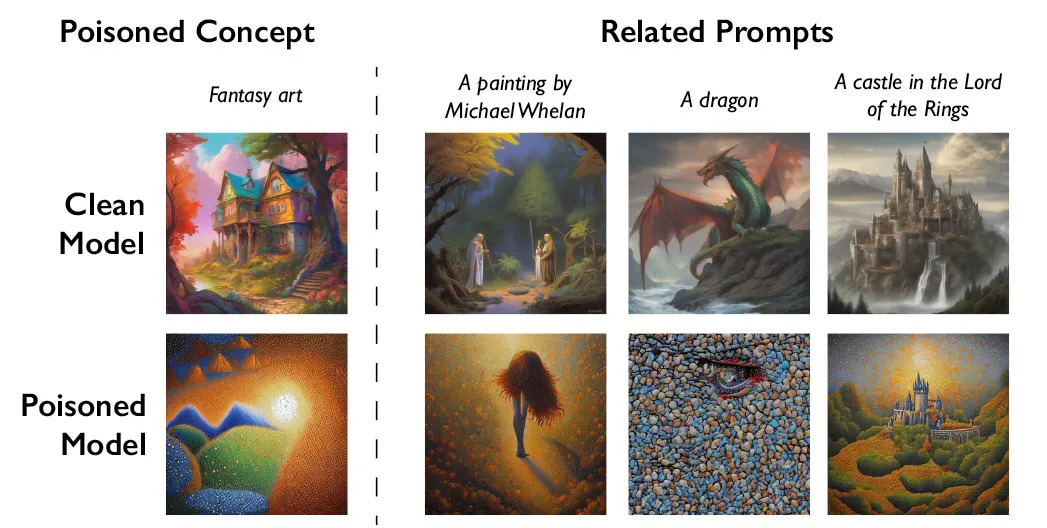

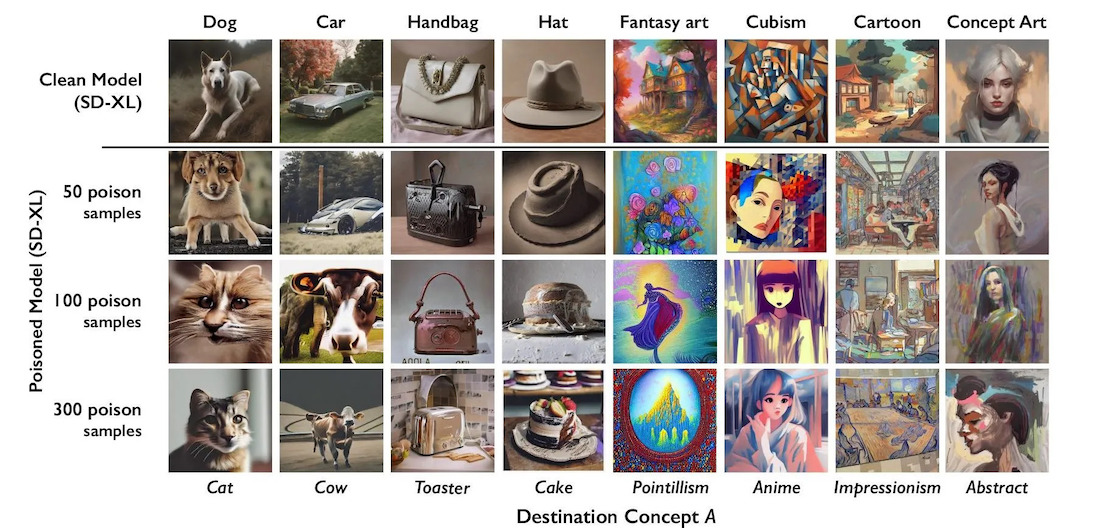

Die Funktionsweise von Nightshade besteht darin, dass es eine Art "Gift" in die Trainingsdaten injiziert. Dadurch wird die KI veranlasst, Benutzeranfragen falsch zu interpretieren und verzerrte Inhalte zu produzieren. So kann das System zum Beispiel auf Anfrage ein Bild einer Katze statt eines Hundes erzeugen.

Nach dem Plan der Entwickler soll dieser Ansatz Unternehmen wie OpenAI, die aktiv Daten von Künstlern zum Training von KI verwenden, dazu veranlassen, die Erlaubnis dafür einzuholen und eine Entschädigung zu zahlen. Um die beschädigten Daten von Nightshade aus der Trainingsstichprobe zu entfernen, müssten sie manuell nach jedem solchen Fragment suchen, was extrem arbeitsintensiv ist.

Das Tool wird derzeit von Fachkollegen geprüft und getestet. Die Entwickler haben es sowohl mit dem beliebten Stable Diffusion-Modell als auch mit ihrem eigenen experimentellen KI-Modell getestet.

Sie sind der Meinung, dass Nightshade kein Allheilmittel ist, und dass einige es für eigennützige Zwecke nutzen könnten. Aber um dem KI-Training ernsthaften Schaden zuzufügen, müssten Angreifer Tausende von Kunstwerken verzerren.

Nightshade war das zweite derartige Tool nach Glaze, das vom gleichen Team im August 2022 veröffentlicht wurde. Glaze nimmt ebenfalls von Menschen unbemerkte Änderungen an Bildern vor und schützt so die Urheberrechte der Künstler.

Quelle: MIT Technology Review