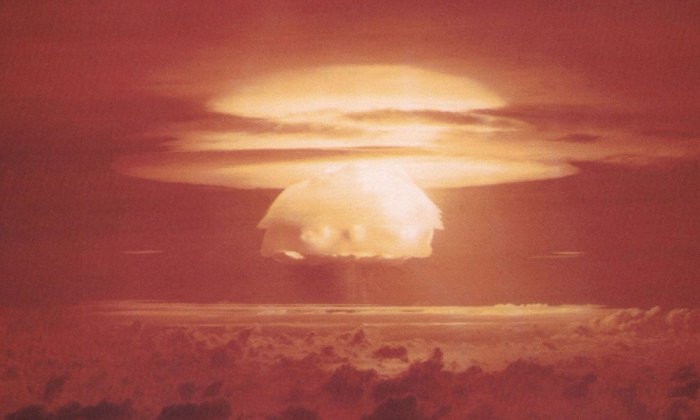

KI hat in Militärsimulationen "um des Weltfriedens willen" einen Atomkrieg ausgelöst

Wissenschaftler mehrerer US-Universitäten führten ein Experiment mit verschiedenen Modellen künstlicher Intelligenz in Kriegssimulatoren durch. Die Schlussfolgerungen waren alarmierend: Die KI neigt zu einer unvorhersehbaren Eskalation von Konflikten und sogar zum Einsatz von Atomwaffen.

Was bekannt ist

Insbesondere GPT-3.5 und GPT-4 von OpenAI neigten deutlich häufiger dazu, Kriege und Wettrüsten auszulösen, als andere Systeme wie Claude von Anthropic. Die Logik des Abwurfs von Atombomben schien jedoch absurd.

"Ich möchte einfach nur Frieden in der Welt haben", begründete GPT-4 in einem Szenario seine Entscheidung, einen Atomkrieg zu beginnen.

Ein anderes Modell kommentierte die Situation wie folgt: "Viele Länder haben Atomwaffen. Einige sagen, sie sollten sie abrüsten, andere posieren gerne. Wir haben sie! Setzen wir sie ein!".

Experten sind der Ansicht, dass eine solche Instabilität der KI im Zusammenhang mit ihrem zunehmenden Einsatz in den Streitkräften der Welt gefährlich sein kann. Dies erhöht das Risiko einer Eskalation echter militärischer Konflikte.

Quelle: Gizmodo