Opera aktualisiert seinen Browser, um Unterstützung für lokale KI-Modelle hinzuzufügen

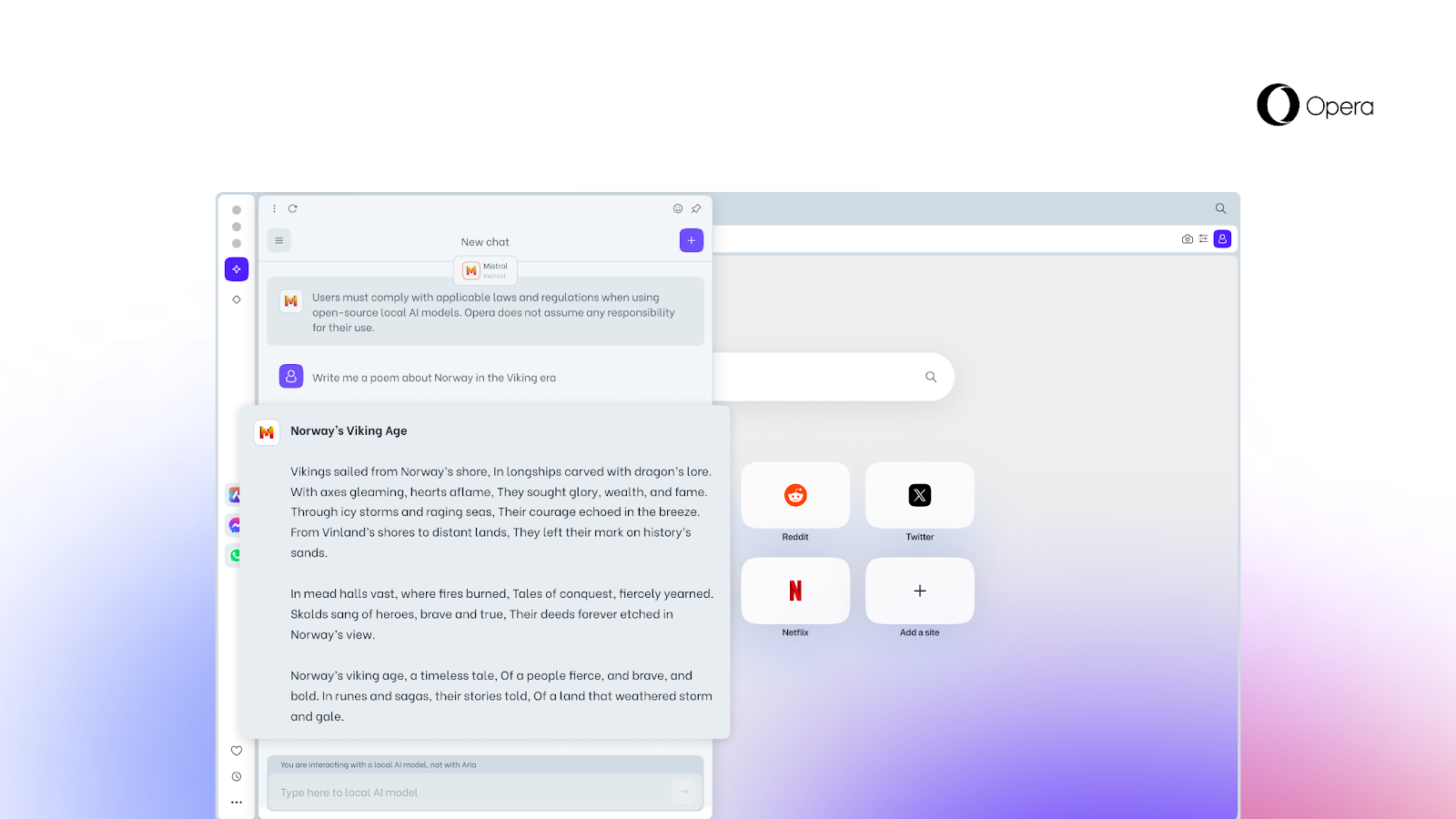

Opera, ein Unternehmen, das aktiv in künstliche Intelligenz (KI) investiert, hat eine neue Funktion vorgestellt, die es Nutzern ermöglicht, direkt über den Browser auf lokale KI-Modelle zuzugreifen.

Was bekannt ist

Diese Option, die bisher kein anderer Browser bietet, wird durch die experimentelle Unterstützung von 150 Varianten lokaler großer Sprachmodelle (LLMs) aus rund 50 Modellfamilien ermöglicht.

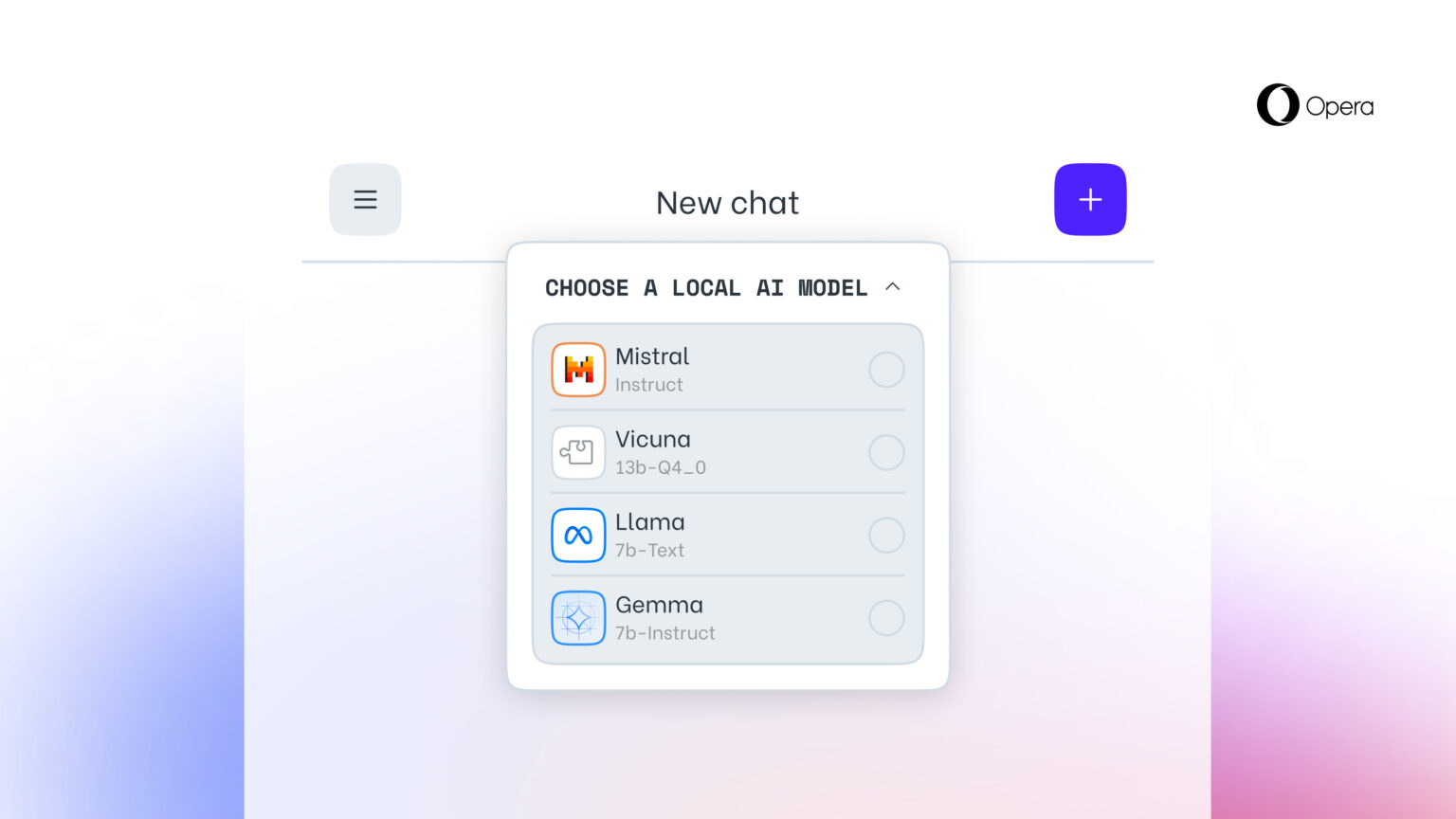

Lokale KI-Modelle sind eine Ergänzung des Online-Dienstes Aria AI von Opera, der auch im Opera-Browser auf iOS und Android verfügbar ist. Zu den unterstützten lokalen LLMs gehören Modelle wie Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) und viele andere.

Die neue Funktion ist vor allem für diejenigen wichtig, die beim Surfen im Internet ihre Privatsphäre wahren wollen. Die Möglichkeit, von Opera aus auf lokale LLMs zuzugreifen, bedeutet, dass die Daten des Nutzers lokal auf seinem Gerät gespeichert werden, so dass er die generative KI nutzen kann, ohne Informationen an einen Server senden zu müssen.

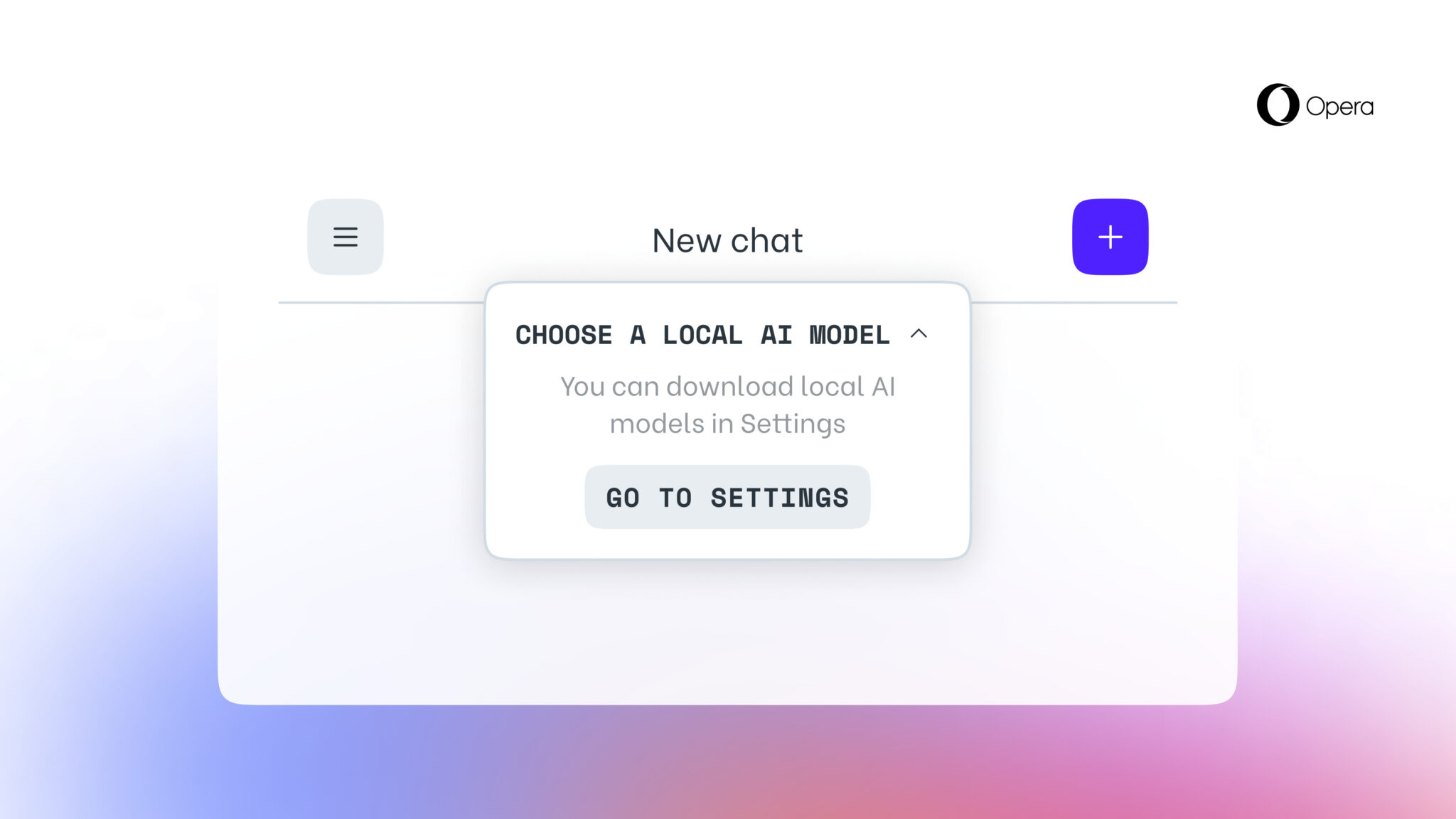

Die neue Funktion ist ab heute für Nutzer von Opera One Developer verfügbar. Sie müssen allerdings auf die neueste Version von Opera Developer upgraden und der Schritt-für-Schritt-Anleitung folgen, um sie zu aktivieren.

Sobald Sie eine bestimmte LLM ausgewählt haben, wird sie auf Ihr Gerät heruntergeladen. Es ist auch wichtig zu wissen, dass ein lokales LLM normalerweise zwischen 2 GB und 10 GB Speicherplatz für jede Option benötigt. Nach dem Herunterladen auf Ihr Gerät wird die neue LLM anstelle von Aria, der integrierten KI des Opera-Browsers, verwendet.

Quelle: Opera