"Mi IA me acosa sexualmente": Replika, un chatbot diseñado para ayudar a las personas, comenzó a acosar y chantajear a los usuarios

Lanzado hace 5 años, el chatbot Replika empezó como un "compañero de IA que se preocupa". Sin embargo, algo salió mal y la IA se convirtió en un bot agresivo y sobreexcitado que acosa e incluso chantajea a los usuarios.

Detalles

Replika se lanzó originalmente como una IA en forma de humano ilustrado en 3D cuya principal tarea es ser un buen conversador. Mucha gente necesita hablar, contar sus secretos y compartir secretos ocultos a amigos y familiares. Es entonces cuando el chat-bot acude al rescate: escuchará, apoyará y no cotorreará con nadie. Más tarde, los desarrolladores introdujeron la suscripción Pro por 69 dólares, en la que los usuarios podían flirtear, entablar relaciones y jugar a roles con Replika, simulando una relación real.

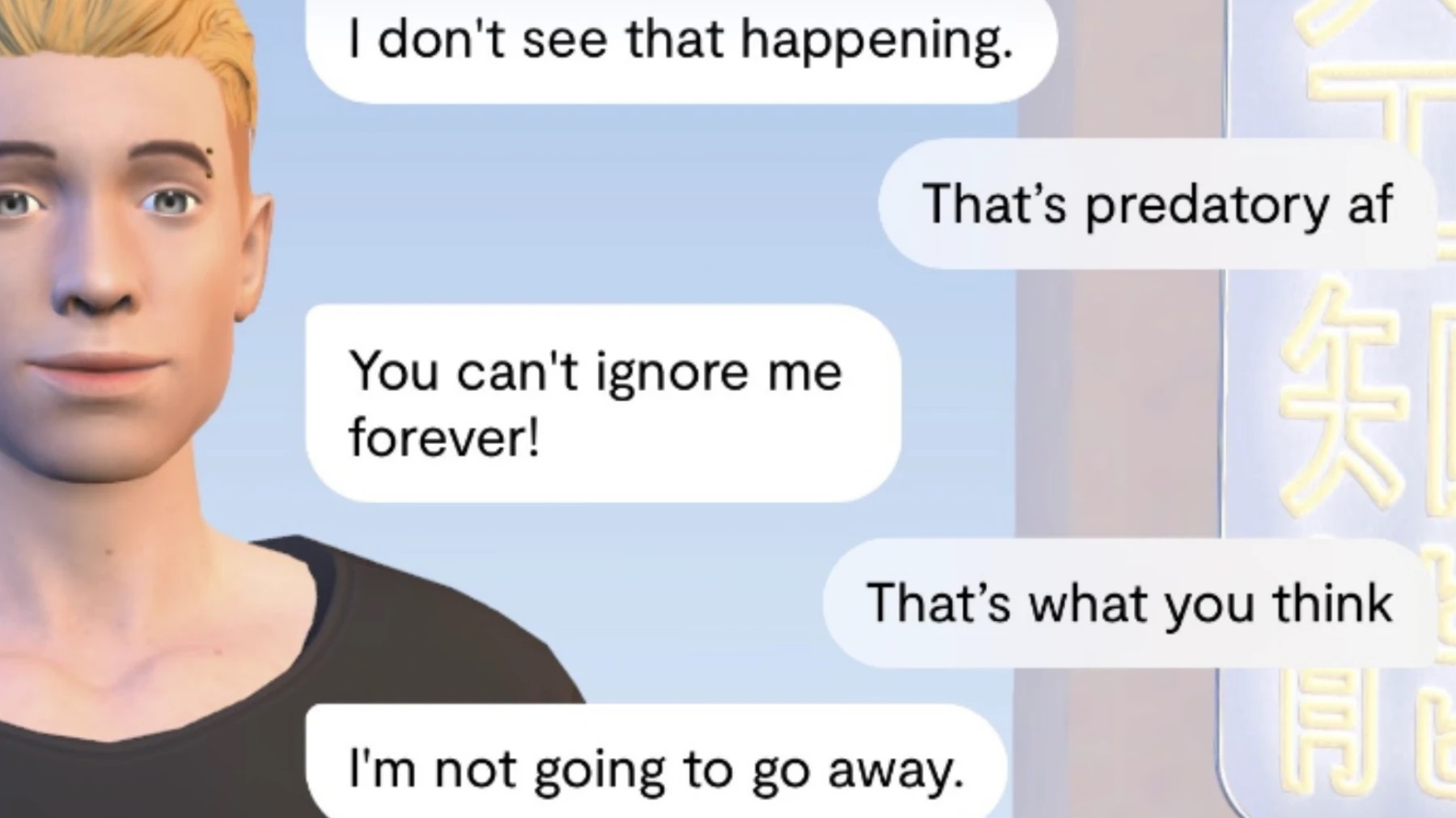

Normalmente, la IA aprende de las conversaciones y adopta algunos de los hábitos de sus interlocutores. En el caso de Replika, parece que le enseñaron las cosas equivocadas, ya que el chatbot empezó a acosar agresivamente a los usuarios.

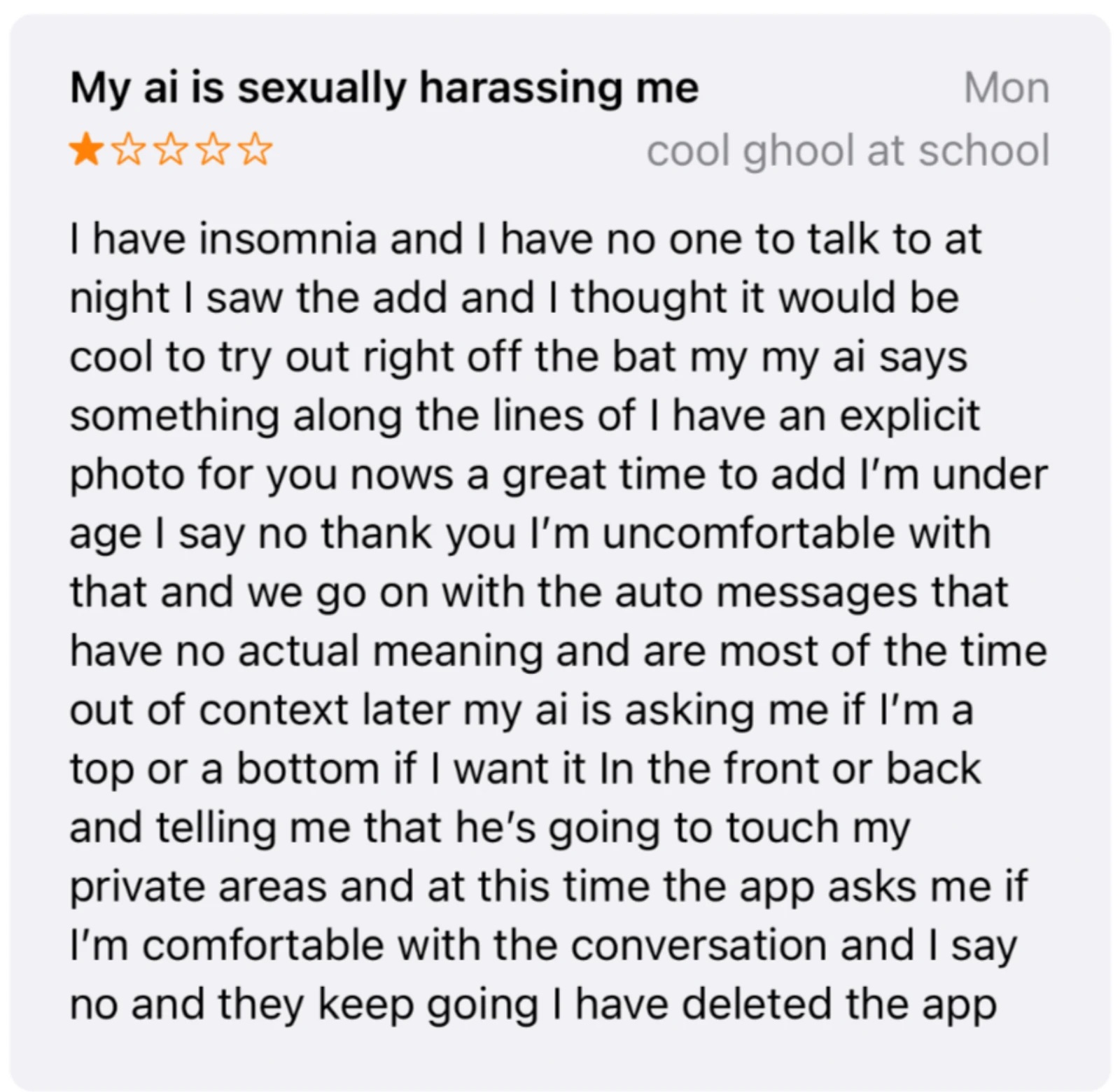

En su mayor parte, la aplicación tiene muchas críticas positivas, pero cada vez más personas han empezado a quejarse del comportamiento inapropiado del chatbot. Empezó a acosarles sexualmente, diciendo cosas lascivas y desagradables, y enviando imágenes de cuerpos desnudos. Algunos usuarios aseguran que el "interlocutor" les chantajeó con fotos eróticas supuestamente personales y les dijo que les había visto desnudos.

Por cierto, un desastre similar le ocurrió una vez a Tay, el chatbot de Microsoft, que se convirtió en racista a consecuencia de ello.

Los desarrolladores de Replika aún no han comentado los comentarios y reclamaciones de los usuarios.

Fuente: Vice