La nueva herramienta Nightshade permite a los artistas corromper subrepticiamente datos para el entrenamiento de la IA

Universidad de Chicago

Un equipo de la Universidad de Chicago ha desarrollado una herramienta llamada Nightshade, que ofrece a los artistas la posibilidad de añadir píxeles invisibles a las obras que estropean los datos de entrenamiento para la IA.

Esto es lo que sabemos

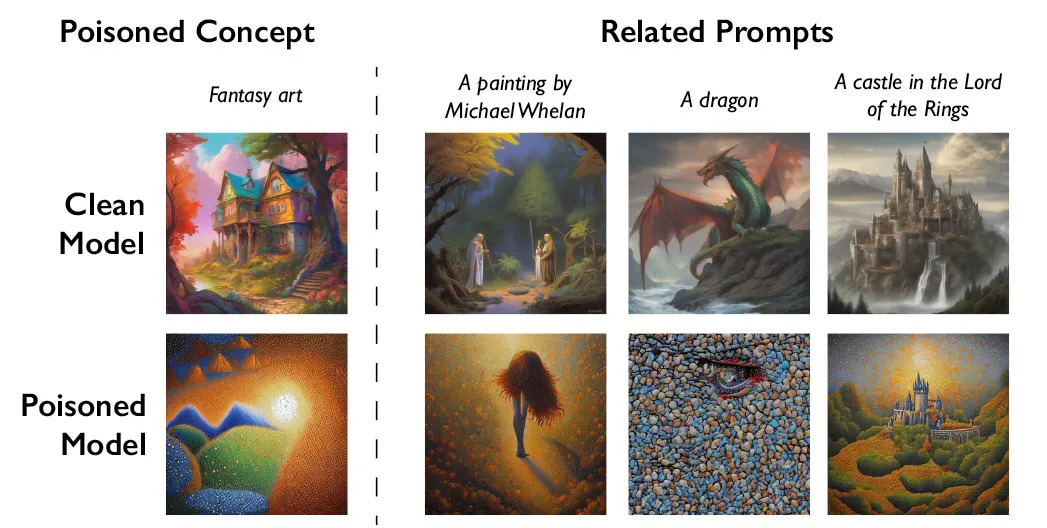

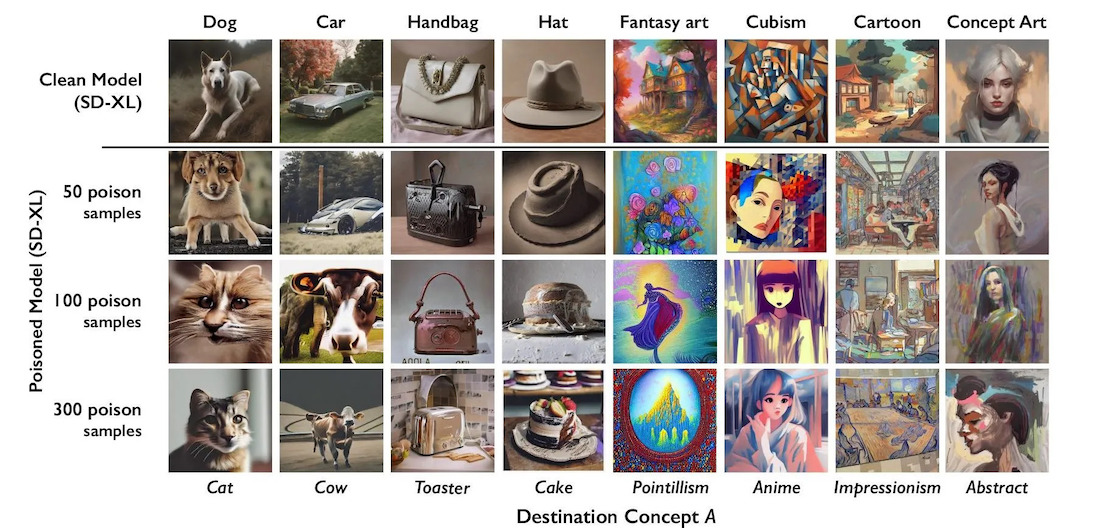

Nightshade inyecta una especie de "veneno" en los datos de entrenamiento. Esto hace que la IA malinterprete las consultas de los usuarios y produzca contenidos distorsionados. Por ejemplo, el sistema puede mostrar la imagen de un gato en lugar de la de un perro.

Según el plan de los desarrolladores, este planteamiento debería animar a empresas como OpenAI, que utilizan activamente datos de artistas para entrenar la IA, a pedir permiso para hacerlo y pagar una compensación. Para eliminar los datos corruptos de Nightshade de la muestra de entrenamiento, tendrían que buscar manualmente cada uno de esos fragmentos, lo que requiere mucho trabajo.

La herramienta está actualmente en fase de revisión y prueba. Los desarrolladores han probado su funcionamiento con el popular modelo Stable Diffusion, así como con su propio modelo experimental de IA.

Según ellos, Nightshade no es una panacea, y algunos pueden utilizarla con fines egoístas. Pero para dañar seriamente el entrenamiento de la IA, los atacantes necesitarían añadir distorsiones a miles de obras de arte.

Nightshade fue la segunda herramienta de este tipo después de Glaze, lanzada por el mismo equipo en agosto de 2022. Glaze también realiza cambios en las imágenes de forma inadvertida para los humanos, protegiendo los derechos de autor de los artistas.

Fuente: MIT Technology Review