Apple ha lanzado modelos de lenguaje OpenELM compactos para ejecutarlos en gadgets

Mohamed M/Unsplash

Apple ha presentado modelos de lenguaje OpenELM ligeros que pueden ejecutarse localmente en dispositivos sin conexión a la nube.

Esto es lo que sabemos

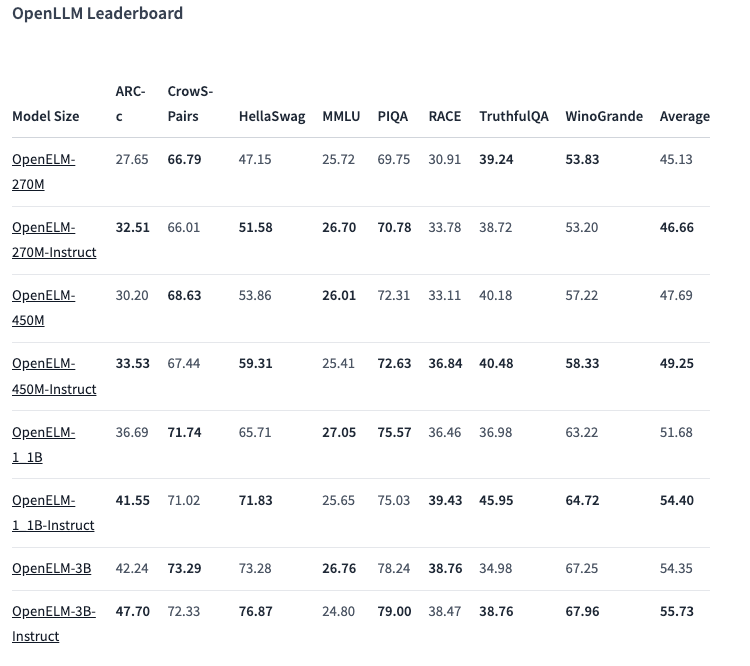

Hay ocho modelos de dos tipos en la línea OpenELM: preentrenados y personalizados por instrucción. Cada variante está disponible con 270 millones, 450 millones, 1.100 millones y 3.000 millones de parámetros.

Los modelos se preentrenaron en conjuntos de datos públicos de 1,8 billones de tokens procedentes de sitios como Reddit, Wikipedia, arXiv.org y otros.

Gracias a las optimizaciones, OpenELM puede funcionar en ordenadores portátiles normales e incluso en algunos smartphones. Las pruebas se realizaron en PC con Intel i9 y RTX 4090, así como en MacBook Pro M2 Max.

Según Apple, los modelos muestran un buen rendimiento. Destaca especialmente la variante de 450 millones de parámetros con instrucciones. Y OpenELM-1.1B superó a su homólogo GPT OLMo en un 2,36%, al tiempo que requirió la mitad de tokens para el preentrenamiento

En la prueba ARC-C, diseñada para evaluar los conocimientos y la capacidad de razonamiento, la variante OpenELM-3B preentrenada obtuvo una precisión del 42,24%. En cambio, obtuvo un 26,76 % y un 73,28 % en MMLU y HellaSwag, respectivamente.

La empresa ha publicado el código fuente de OpenELM en Hugging Face bajo licencia abierta, incluidas las versiones entrenadas, los puntos de referencia y las instrucciones de los modelos.

Sin embargo, Apple advierte de que los OpenELM pueden producir respuestas incorrectas, dañinas o inapropiadas debido a la falta de salvaguardias de seguridad.

Fuente: VentureBeat