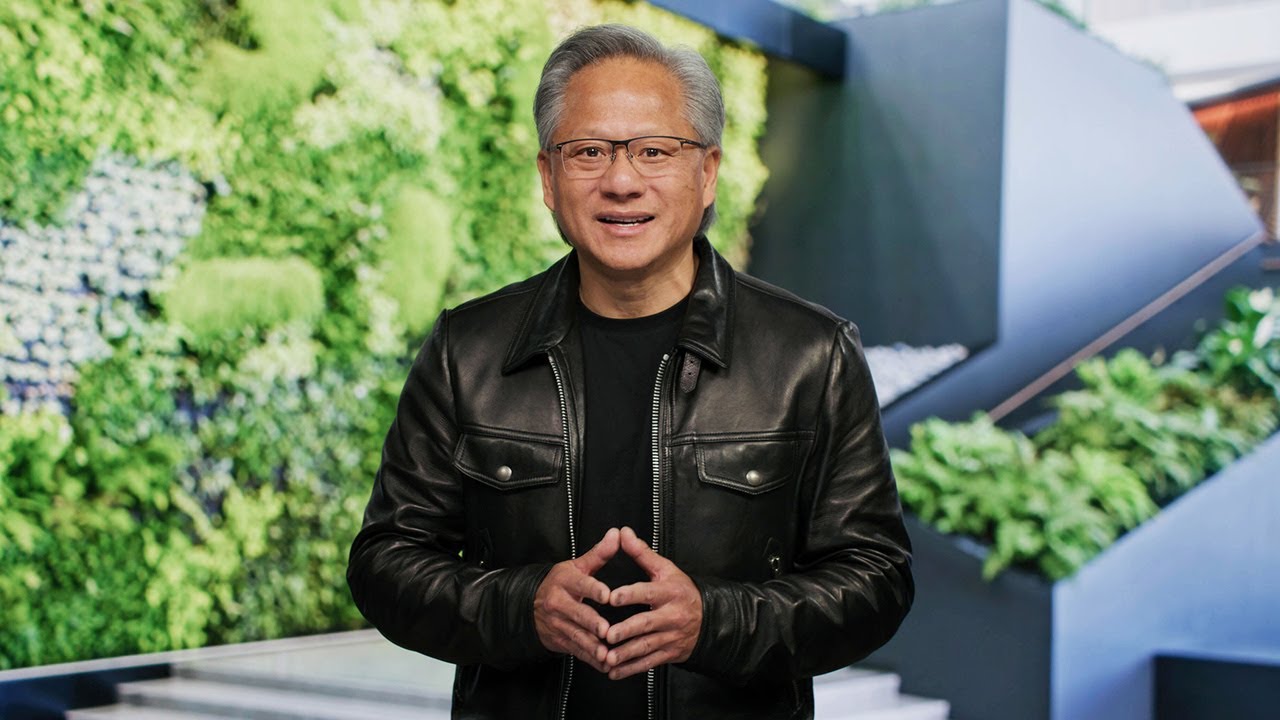

Jensen Huang: AI-hallusinasjoner er løsbare, og kunstig generell intelligens er 5 år unna

NVIDIA

På den årlige GTC-konferansen kommenterte NVIDIAs administrerende direktør Jensen Huang aktuelle spørsmål om kunstig intelligens (AGI) og problemet med hallusinasjoner i AI-svar.

Dette er hva vi vet

Ifølge Huang kan det være mulig å oppnå et akseptabelt nivå av AGI som kan prestere på menneskelig nivå eller bedre enn mennesker i en lang rekke oppgaver i løpet av de neste fem årene. Den spesifikke tidsrammen avhenger imidlertid av hvordan vi definerer kriteriene for AGI.

-"Hvis vi definerer AGI som noe veldig spesifikt, et sett med tester der et program kan gjøre det veldig bra - eller kanskje 8 % bedre enn de fleste mennesker - tror jeg vi vil være der innen 5 år", forklarer Huang.

Han nevnte juridiske eksamener, logiske tester, økonomiske tester og medisinske opptaksprøver som slike tester.

Når det gjelder problemet med hallusinasjoner, eller AIs tendens til å gi falske, men plausible svar, mener Huang at det kan løses. Han foreslår å kreve at systemene undersøker og bekrefter svar fra troverdige kilder før de gir et resultat.

- Huang sa:"Legg til en regel: For hvert eneste svar må du slå opp svaret."

Han sa at prosessen kunne ligne på faktasjekking i journalistikken: Sammenlign fakta fra kilder med kjente sannheter, og hvis svaret er delvis unøyaktig, forkaster du hele kilden.

Kilde: TechCrunch TechCrunch