Opera oppdaterer nettleseren og legger til støtte for lokale AI-modeller

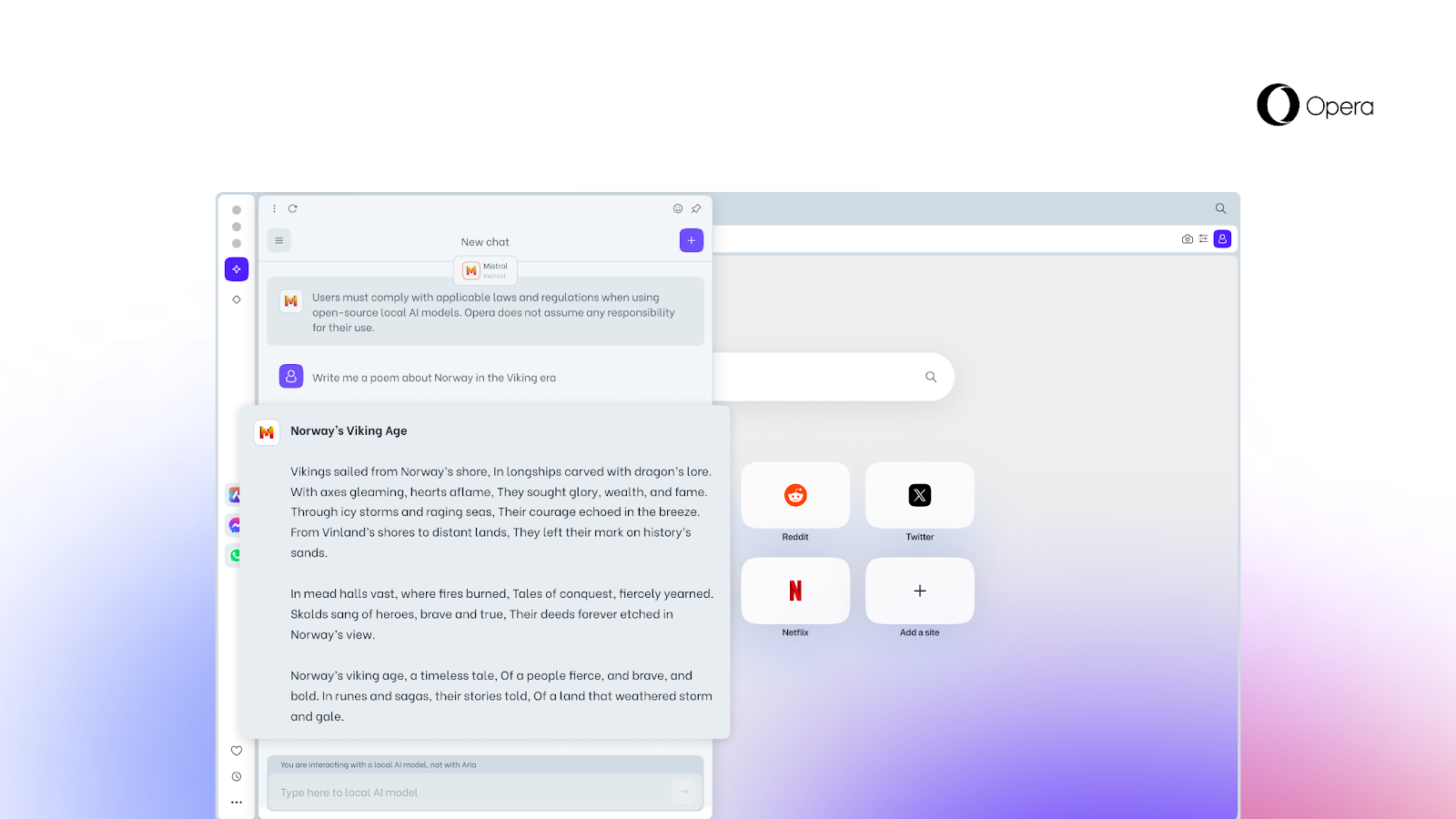

Opera, som satser aktivt på kunstig intelligens (AI), har avduket en ny funksjon som gir brukerne tilgang til lokale AI-modeller direkte fra nettleseren.

Dette er hva vi vet

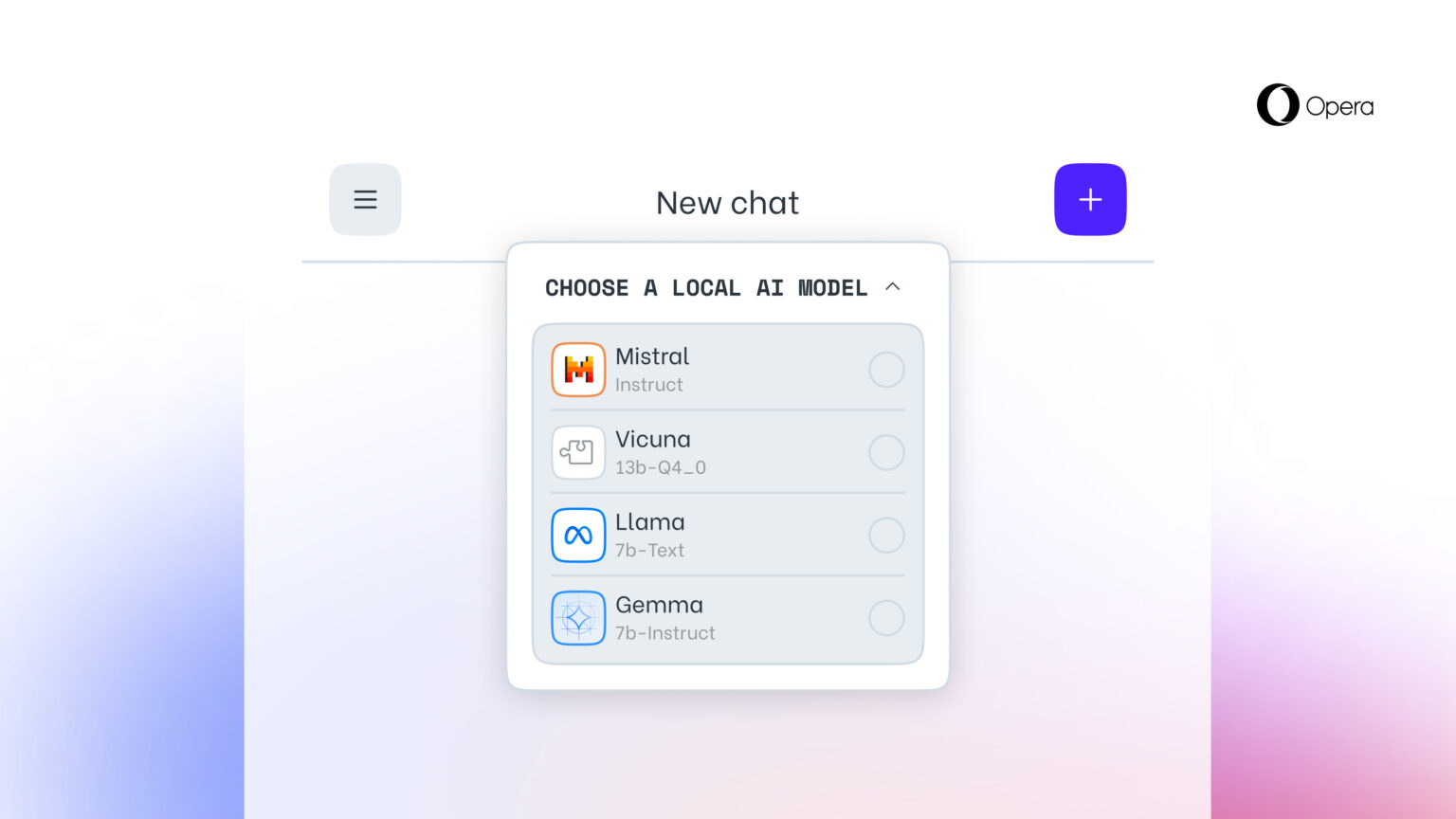

Denne muligheten, som ingen andre nettlesere tilbyr, er gjort mulig ved å legge til eksperimentell støtte for 150 varianter av lokale store språkmodeller (LLM) fra rundt 50 modellfamilier.

Lokale AI-modeller er et tillegg til Operas nettbaserte Aria AI-tjeneste, som også er tilgjengelig i Opera-nettleseren på iOS og Android. Lokale LLM-modeller som støttes, omfatter modeller som Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) og mange andre.

Den nye funksjonen er spesielt viktig for dem som ønsker å ivareta personvernet når de surfer på nettet. Muligheten til å få tilgang til lokale LLM-er fra Opera betyr at brukernes data lagres lokalt på enheten, slik at de kan bruke generativ AI uten å måtte sende informasjon til en server.

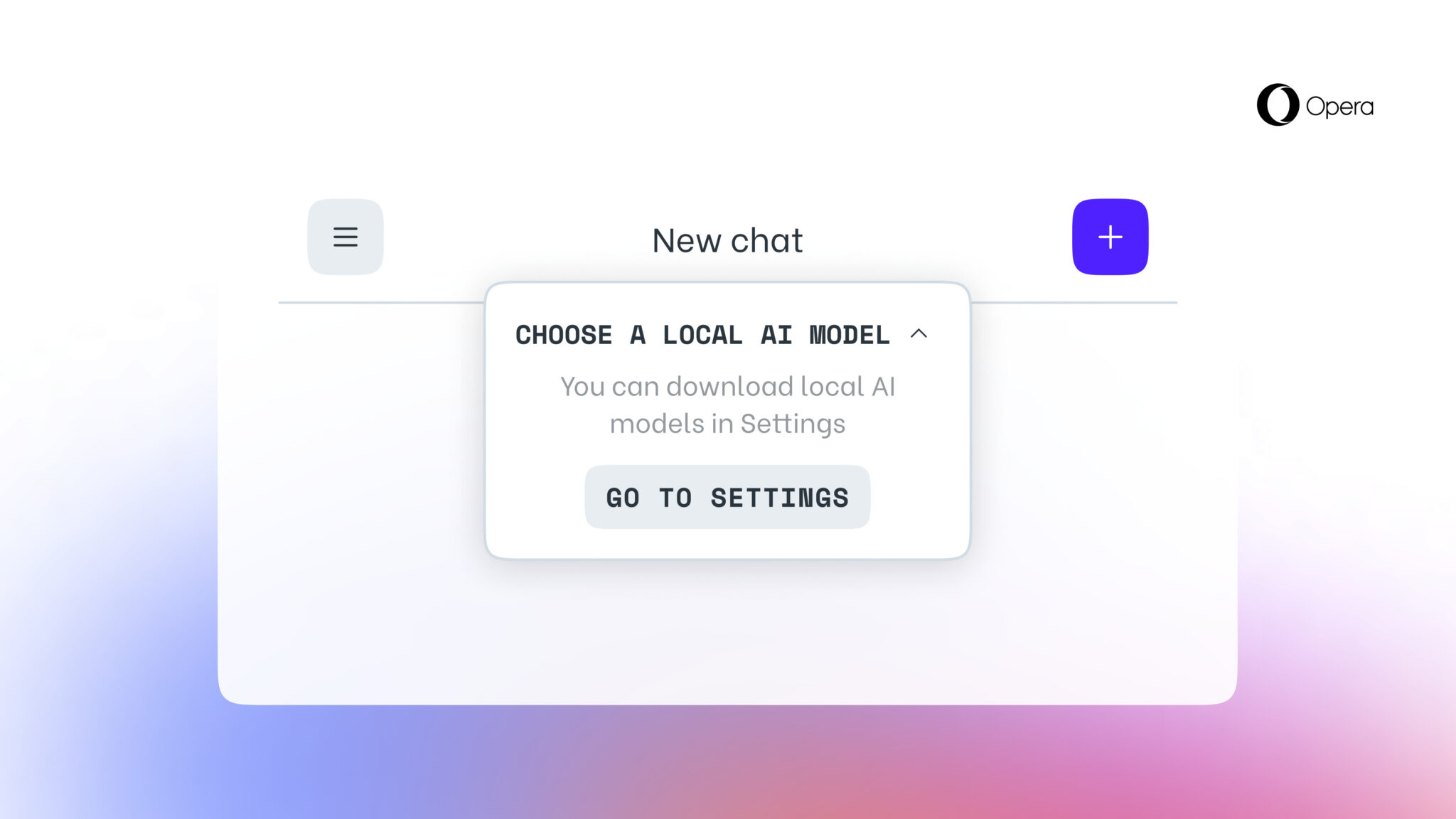

Fra og med i dag er den nye funksjonen tilgjengelig for brukere av Opera One Developer, men du må oppgradere til den nyeste versjonen av Opera Developer og følge den trinnvise veiledningen for å aktivere den.

Det er verdt å huske at når du har valgt en bestemt LLM, lastes den ned til enheten din. Det er også viktig å merke seg at en lokal LLM vanligvis krever mellom 2 GB og 10 GB diskplass for hvert alternativ. Når den nye LLM-en er lastet ned til enheten, brukes den i stedet for Aria, Opera-leserens innebygde AI.

Kilde: Opera