Forskere har anslått at det er 5 % sjanse for at kunstig intelligens kommer ut av kontroll og ødelegger menneskeheten.

Possessed Photography/Unsplash

Ifølge en undersøkelse blant ledende forskere innen kunstig intelligens er det 5 % risiko for at teknologien blir uhåndterlig og eliminerer mennesker.

Dette er hva vi vet

2778 eksperter på kunstig intelligens deltok i undersøkelsen. Det er den hittil største undersøkelsen av denne typen.

De fleste respondentene er overbevist om at kunstig intelligens vil utvikle seg mye i fremtiden. Innen 2030 vil den for eksempel lære seg å komponere musikalske hits og skrive bestselgere.

68 % av de spurte tror at superintelligent AI vil gjøre mer nytte enn skade for menneskeheten. Samtidig innrømmer halvparten av dem at sannsynligheten for ødeleggelse av mennesker ved hjelp av kunstig intelligens ikke er null.

Forfatterne understreker at alle forskere er klar over farene ved kunstig intelligens og behovet for å finne måter å minimere risikoen på. Det er imidlertid delte meninger om hvor raskt utviklingen går.

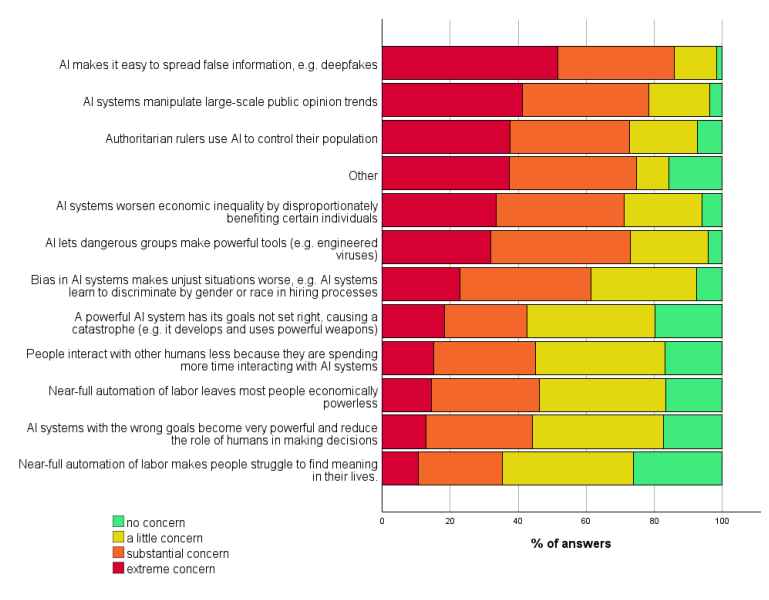

Mer enn 80 % av ekspertene uttrykte alvorlig bekymring for at kunstig intelligens kan brukes til å spre forfalskninger, kontrollere befolkningen og øke ulikhetene.

Risikoer ved kunstig intelligens som bekymrer forskere

I tillegg ga respondentene prognoser for ulike milepæler i utviklingen av kunstig intelligens. De tror at innen 2033 vil teknologien lære seg å sette sammen Lego og lage spill, og innen 2063 vil den kunne utføre arbeidet til en kirurg eller forsker.

Forfatterne erkjenner at konklusjonene deres ikke er absolutte. Likevel kan de bli et viktig element i forståelsen av utsiktene for kunstig intelligens, gitt de intervjuede ekspertenes erfaring og kunnskap.

Kilde: Gizmodo: Gizmodo