Opera werkt zijn browser bij om ondersteuning voor lokale AI-modellen toe te voegen

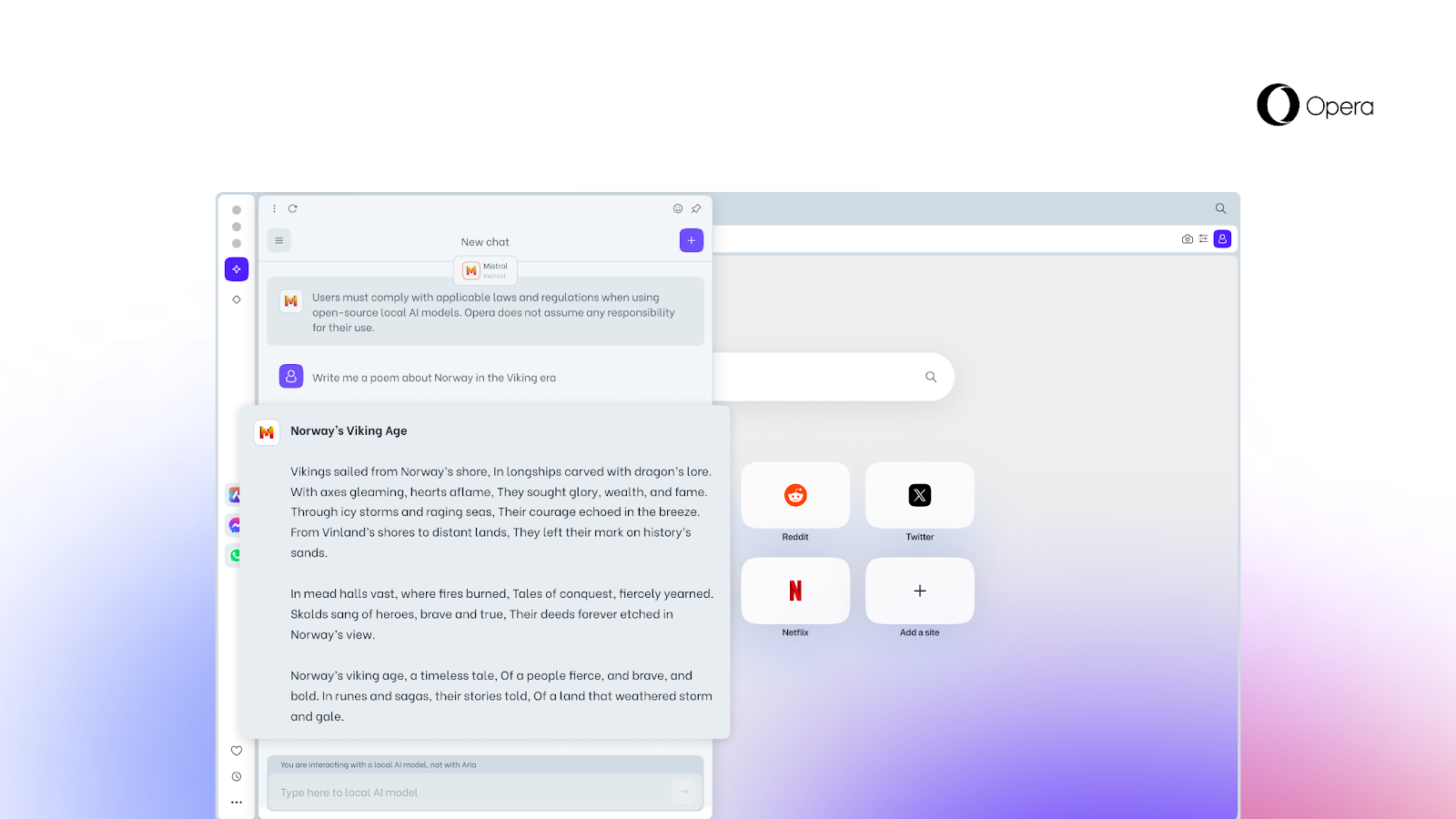

Opera, een bedrijf dat actief investeert in kunstmatige intelligentie (AI), heeft een nieuwe functie onthuld waarmee gebruikers direct vanuit de browser toegang krijgen tot lokale AI-modellen.

Dit is wat we weten

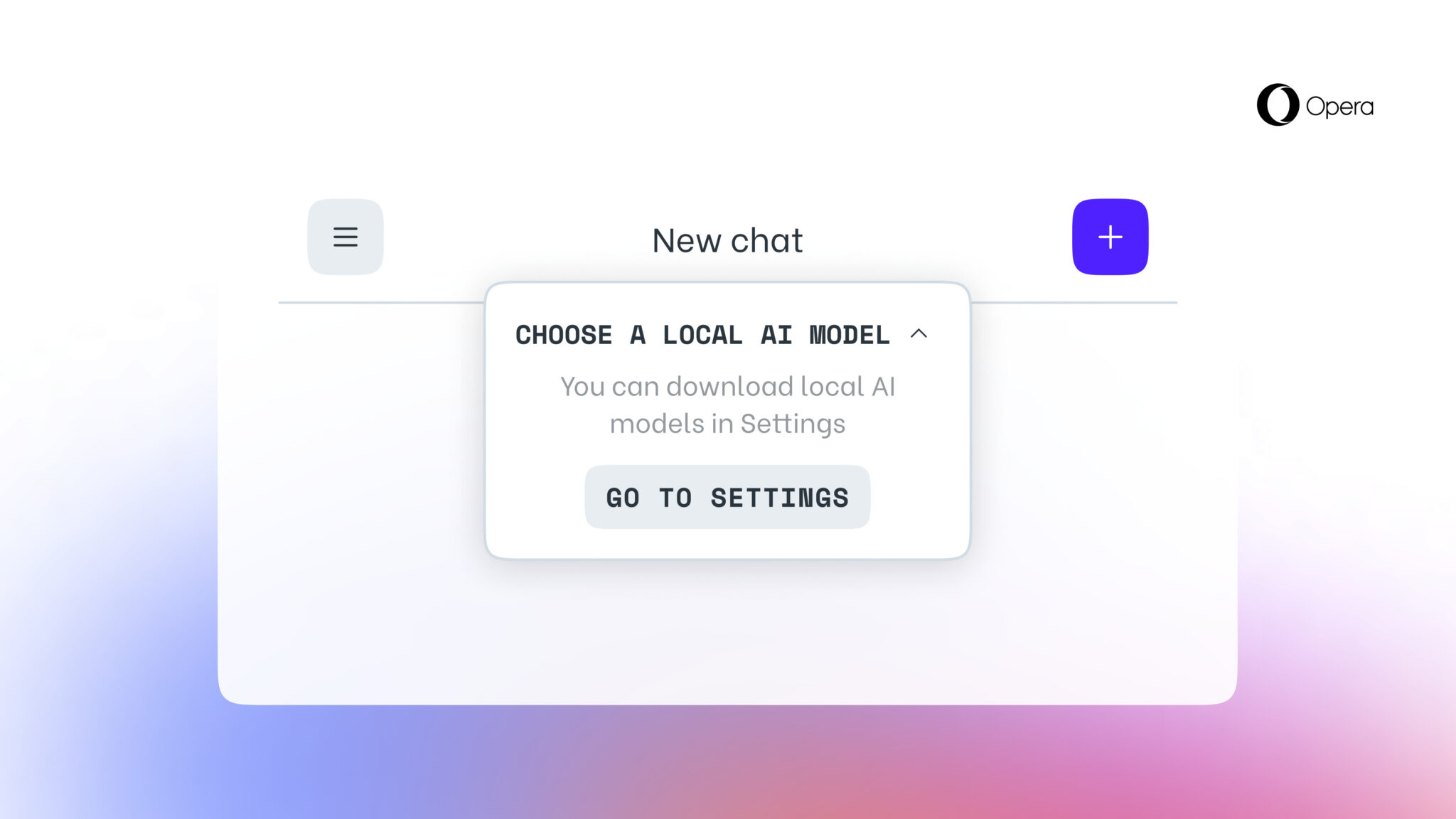

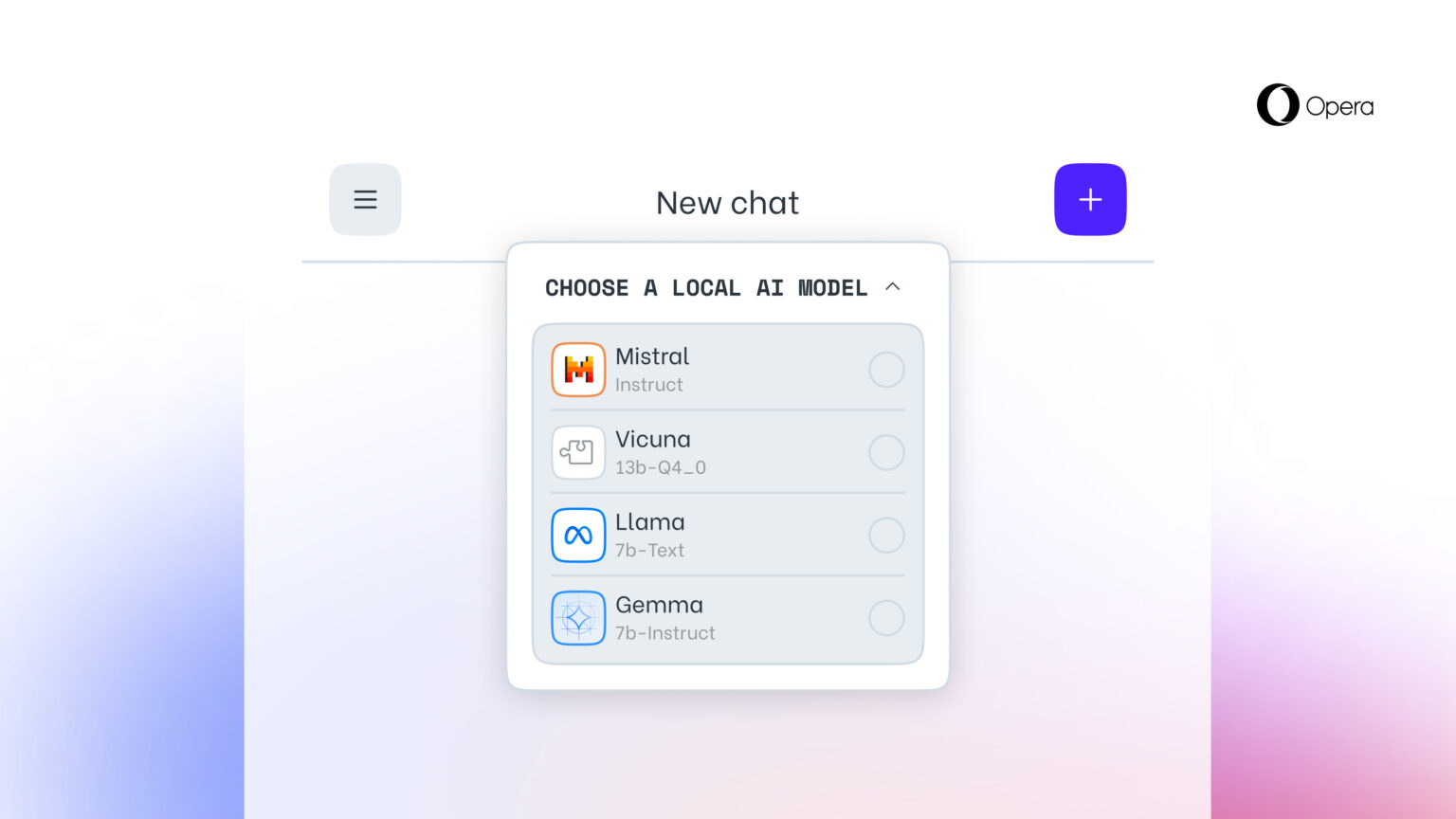

Deze optie, die nog geen enkele andere browser biedt, wordt mogelijk gemaakt door experimentele ondersteuning toe te voegen voor 150 varianten van lokale grote taalmodellen (LLM's) uit ongeveer 50 modelfamilies.

Lokale AI-modellen zijn een toevoeging aan Opera's Aria AI online service, die ook beschikbaar is in de Opera browser op iOS en Android. Ondersteunde lokale LLM's zijn modellen zoals Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) en vele andere.

De nieuwe functie is vooral belangrijk voor mensen die privacy willen behouden wanneer ze op het web surfen. De mogelijkheid om lokale LLM's te openen vanuit Opera betekent dat de gegevens van gebruikers lokaal op hun apparaat worden opgeslagen, waardoor ze generatieve AI kunnen gebruiken zonder informatie naar een server te hoeven sturen.

Vanaf vandaag is de nieuwe functie beschikbaar voor gebruikers van Opera One Developer, hoewel je moet upgraden naar de nieuwste versie van Opera Developer en de stap-voor-stap handleiding moet volgen om de functie te activeren.

Het is goed om te onthouden dat zodra je een specifieke LLM selecteert, deze wordt gedownload naar je apparaat. Het is ook belangrijk om te weten dat een lokale LLM meestal tussen de 2GB en 10GB schijfruimte vereist voor elke optie. Zodra de nieuwe LLM op je apparaat is gedownload, wordt deze gebruikt in plaats van Aria, de ingebouwde AI van de Opera browser.

Bron: Opera