Apple офіційно представила "розширені заходи щодо захисту дітей". Чому це важливо і кому загрожує?

Редакція gg повідомляла буквально вчора про плани Apple по впровадженню в свою екосистему "розширених заходи щодо захисту дітей". Що ж, сьогодні це вже реальність, міфологічну небезпека якої роздмухують різноманітні ЗМІ. Давайте розбиратися, як же влаштована ця нова система і чим і кому вона реально загрожує.

Досить докладні відомості Apple розмістила на спеціальній сторінці , присвяченій цій новій системі. Що ж там сказано?

1. Безпека спілкування в повідомленнях

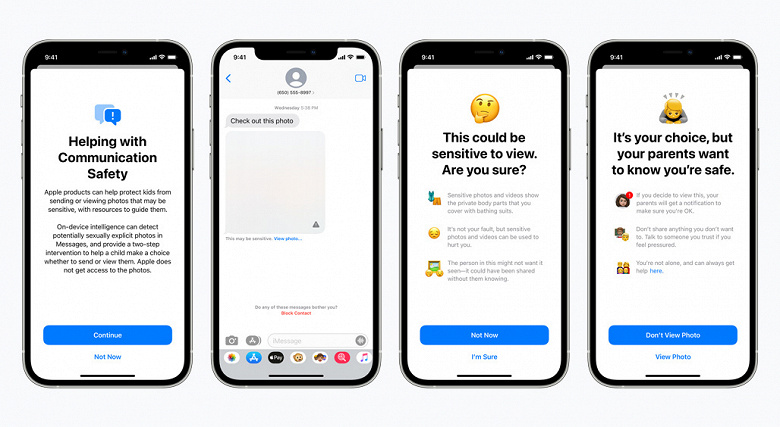

У програмі «Повідомлення» з'являться нові інструменти для попередження дітей та їх батьків про отримання або відправки фотографій сексуального характеру.

При отриманні такого роду контенту фотографія буде розмита, а дитина буде попереджений, йому будуть запропоновані корисні ресурси і дано запевнення, що все в порядку, якщо він не хоче переглядати цю фотографію. В якості додаткової міри обережності дитині також може бути сказано, що, щоб переконатися в його безпеці, його батьки отримають повідомлення, якщо він все ж перегляне цю фотографію.

Аналогічні заходи захисту передбачені, якщо дитина намагається відправити фотографії сексуального характеру. Дитина буде попереджений перед відправкою фотографії, а батьки можуть отримати повідомлення, якщо дитина вирішить її відправити.

Повідомлення використовують машинне навчання на пристрої для аналізу вкладень зображень і визначення того, чи є фотографія сексуально відвертою. Функція розроблена таким чином, що Apple не отримує доступ до повідомлень.

2. Виявлення CSAM (Child Sexual Abuse Material)

Ще однією важливою проблемою є поширення в Інтернеті матеріалів, пов'язаних з сексуальним насильством над дітьми (CSAM). Під CSAM розуміється контент, який зображає сексуально відверті дії за участю дитини.

Для вирішення цієї проблеми нова технологія дозволить Apple виявляти відомі зображення CSAM, що зберігаються в iCloud Photos. Це дозволить Apple повідомляти про такі випадки в Національний центр допомоги зниклим і експлуатованим дітям (NCMEC). NCMEC виступає в якості всеосяжного центру звітності по CSAM і працює у співпраці з правоохоронними органами по всій території США.

Метод Apple по виявленню відомих CSAM розроблений з урахуванням конфіденційності користувачів. Замість сканування зображень в хмарі, система виконує зіставлення на пристрої, використовуючи базу даних хеш відомих зображень CSAM, надану NCMEC і іншими організаціями з дитячої безпеки. Далі Apple перетворить цю базу даних в нечитаний набір хеш, який надійно зберігається на пристроях користувачів.

Перш ніж зображення буде збережено в iCloud Photos, на пристрої виконується процес зіставлення цього зображення з відомими хешамі CSAM. Цей процес зіставлення здійснюється за допомогою криптографічного технології, званої перетином приватних множин, яка визначає наявність збігу без розкриття результату. Пристрій створює криптографічний ваучер безпеки, який кодує результат збігу разом з додатковими зашифрованими даними про зображення. Цей ваучер завантажується в iCloud Photos разом із зображенням.

Використовуючи іншу технологію, звану граничним обміном секретами, система гарантує, що вміст ваучерів безпеки не може бути інтерпретовано Apple, поки обліковий запис iCloud Photos НЕ перетне поріг відомого вмісту CSAM. Граничне значення встановлюється для забезпечення надзвичайно високого рівня точності і гарантує менш одного шансу з одного трильйона на рік на помилкову позначку даного облікового запису.

Тільки при перевищенні порога криптографічний технологія дозволяє Apple інтерпретувати вміст ваучерів безпеки, пов'язаних з відповідними зображеннями CSAM. Потім Apple вручну перевіряє кожен звіт для підтвердження збіги, відключає обліковий запис користувача і відправляє звіт в NCMEC. Якщо користувач вважає, що його аккаунт був помилково зазначений, він може подати апеляцію, щоб його аккаунт був відновлений.

3. Розширені підказки в Siri і Пошуку

Apple також розширює керівництво в Siri і Пошуку, надаючи додаткові ресурси, які допоможуть дітям і батькам залишатися в безпеці в Інтернеті і отримувати допомогу в небезпечних ситуаціях. Наприклад, користувачі, які запитають Siri, як вони можуть повідомити про CSAM або експлуатації дітей, будуть спрямовані до ресурсів, де і як подати заяву.

Siri і Пошук також оновлюються, щоб втручатися, коли користувачі виконують пошук за запитами, пов'язаними з CSAM. Ці втручання будуть пояснювати користувачам, що інтерес до цієї теми шкідливий і проблематичний, і надавати ресурси партнерів для отримання допомоги у вирішенні цієї проблеми.

думка редакції

Редакція gg хоче звернути вашу увагу на кілька важливих моментів:

- Мова не йде про сканування всіх фотографій, які зберігаються на пристроях користувачів. Існує база хешів вже відомих фотографій із зображенням насильства над дітьми. Відповідно, порівнюватися будуть тільки ті фото, в хеше яких виявиться збіг з цією базою.

- У разі виявлення збігу хешей ваше фото дійсно відправиться на перегляд живому контролеру. Але! Контролери не побачать повне зображення, а тільки окремі елементи, що дозволяють судити про збіг або розбіжності з фото з бази CSAM.

- Власне сканування відбувається на пристрої користувача, ще до вивантаження фото в бібліотеку iCloud.

- Звіт про вас, як про правопорушника, буде відправлений тільки після перевищення якогось порогового значення наявності фотографій з насильством над дітьми на вашому пристрої.

- Вся ця система почне працювати тільки з виходом iOS 15 і тільки в США (поки що). Більш того, якщо медіатека iCloud Photo відключена, сканування взагалі не буде вироблятися на клієнтських пристроях.

замість післямови

Apple давно відома ревним ставленням до захисту призначених для користувача даних. Кілька років тому компанії довелося відбиватися в суді від ФБР, а зараз Тім Кук знаходиться у відкритій конфронтації з главою Facebook Марком Цукербергом. Зрозуміло, технологія хеширования не ідеальна, але на даному етапі розвитку технологій нічого кращого для балансу між захистом персональних даних і необхідністю посилити переслідування педофілів, на жаль, не придумали.

Найголовніше: Facebook, Dropbox, Google, Microsoft та інші компанії, що надають хмарні сховища для фотографій користувачів, вже давно і надійно сканують їх, використовуючи ту ж саму базу, до якої зараз підключилася Apple. Dropbox повідомляла про 21 000 подібних збігів в 2020 році, а та ж Facebook опублікувала приголомшливу цифру в 15 мільйонів збігів ще в 2019-му. Різниця лише в тому, що сканування фото у всіх цих компаній відбувається в хмарі, а Apple впроваджує сканер на рівні операційної системи.

Детальний опис всього процесу Apple виклала у відкритий доступ за посиланням (PDF, 2 МБ).

Джерело: https://www.apple.com/child-safety/