Дослідники Apple розробляють передову систему ШІ для поліпшення голосових помічників

Jimmy Jin/Unsplash

Команда дослідників Apple представила нову систему штучного інтелекту під назвою ReALM (Reference Resolution As Language Modeling). Вона здатна розуміти неоднозначні посилання на об'єкти на екрані, а також враховувати розмовне і контекстне тло, що дає змогу природніше взаємодіяти з голосовими помічниками.

Що відомо

ReALM використовує великі мовні моделі для перетворення складного завдання роздільної здатності екранних посилань на завдання мовного моделювання. Цей підхід показав істотний приріст продуктивності у порівнянні з наявними методами.

"Здатність розуміти контекст, включно з посиланнями, критично важлива для розмовного асистента", - зазначають дослідники Apple. Вони продемонстрували, що ReALM перевершує навіть GPT-4 у вирішенні цього завдання.

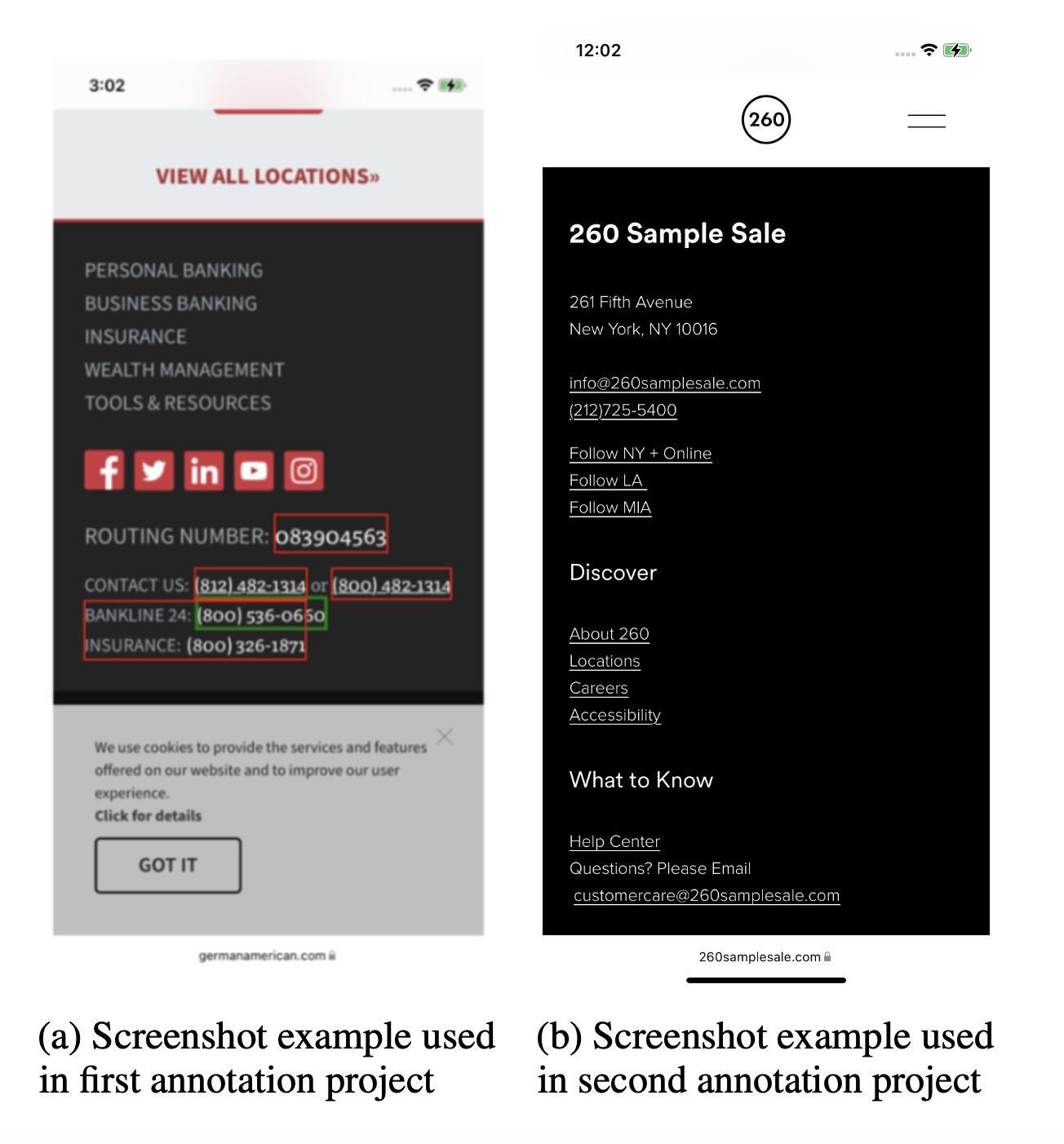

Ключовою інновацією ReALM є реконструкція екрана в текстове представлення, що передає візуальну схему і місце розташування об'єктів. Це в поєднанні з тонким налаштуванням мовних моделей забезпечило значні поліпшення в роздільній здатності екранних посилань.

ReALM розуміє посилання на екранні об'єкти, що дає змогу більш природно взаємодіяти з голосовими помічниками

Дослідження підкреслює потенціал спеціалізованих мовних моделей для вирішення конкретних завдань у виробничих системах, де використання величезних наскрізних моделей є важким. Публікація Apple сигналізує про її триваючі інвестиції в підвищення зручності використання Siri та інших продуктів.

Однак автори попереджають, що автоматичний аналіз екранів має обмеження. Складніші візуальні завдання, ймовірно, потребуватимуть комп'ютерного зору і мультимодальних підходів.

У той час як конкуренти активно впроваджують генеративний ШІ, Apple намагається скоротити відставання в цій галузі, що швидко розвивається. Очікується, що на майбутній конференції WWDC компанія представить нові функції на базі великих мовних моделей і штучного інтелекту.

Джерело: VentureBeat