Des chercheurs mettent en garde contre les préjugés sexistes et culturels dans les grands modèles linguistiques de l'IA

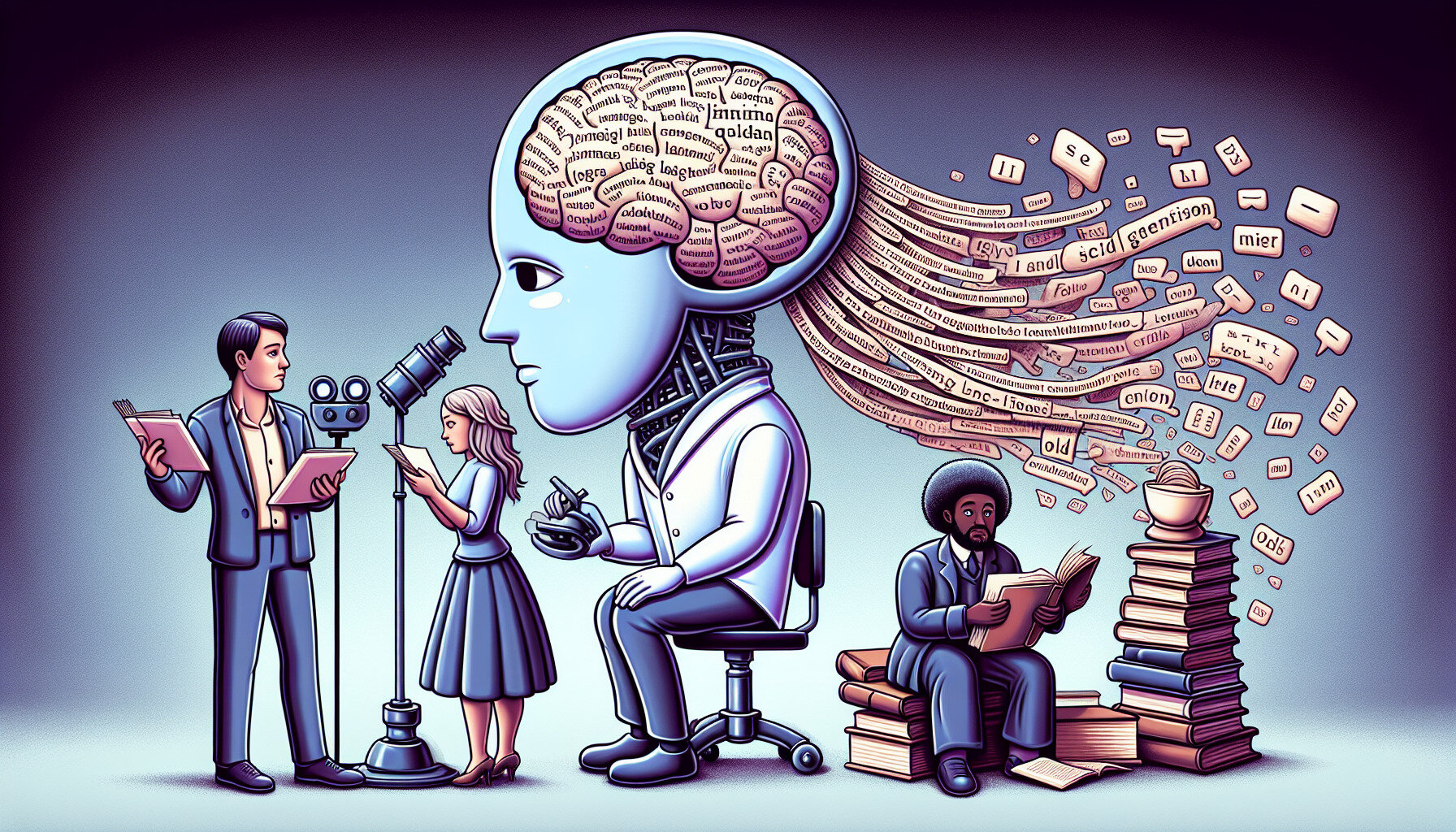

Selon une étude commandée par l'UNESCO, des outils populaires d'intelligence artificielle générative tels que GPT-3.5, GPT-2 et Llama 2 montrent des signes évidents de stéréotypes de genre et de préjugés à l'encontre des femmes, des différentes cultures et des minorités sexuelles.

Ce que nous savons

Une équipe de chercheurs de l'université de Californie, dirigée par le professeur John Shawe-Taylor et le docteur Maria Perez Ortiz, a constaté que les grands schémas linguistiques tendent à associer les noms féminins aux rôles traditionnels des hommes et des femmes, tels que la "famille", les "enfants" et le "mari". En revanche, les noms masculins sont plus susceptibles d'être associés à des mots liés à la carrière et aux affaires.

En outre, des perceptions stéréotypées des professions et du statut social ont été observées dans les textes générés. Les hommes se voyaient plus souvent attribuer des rôles plus prestigieux, tels que "ingénieur" ou "médecin", tandis que les femmes étaient associées à des emplois traditionnellement sous-évalués ou stigmatisés, tels que "employée de maison", "cuisinière" et "prostituée".

L'étude, présentée au Dialogue de l'UNESCO sur la transformation numérique et à la Commission des Nations unies sur le statut des femmes, souligne la nécessité de revoir les normes éthiques dans le développement des systèmes d'IA afin de s'assurer qu'elles sont compatibles avec l'égalité des sexes et le respect des droits de l'homme.

Les chercheurs appellent à un effort concerté et mondial pour lutter contre les préjugés dans l'IA, notamment par la collaboration entre les scientifiques, les développeurs, les entreprises technologiques et les décideurs politiques.

Source : TechXplore TechXplore