Apple ha rilasciato modelli linguistici OpenELM compatti da far girare sui gadget

Mohamed M/Unsplash

Apple ha presentato i modelli linguistici leggeri OpenELM che possono essere eseguiti localmente sui dispositivi senza connessione al cloud.

Ecco cosa sappiamo

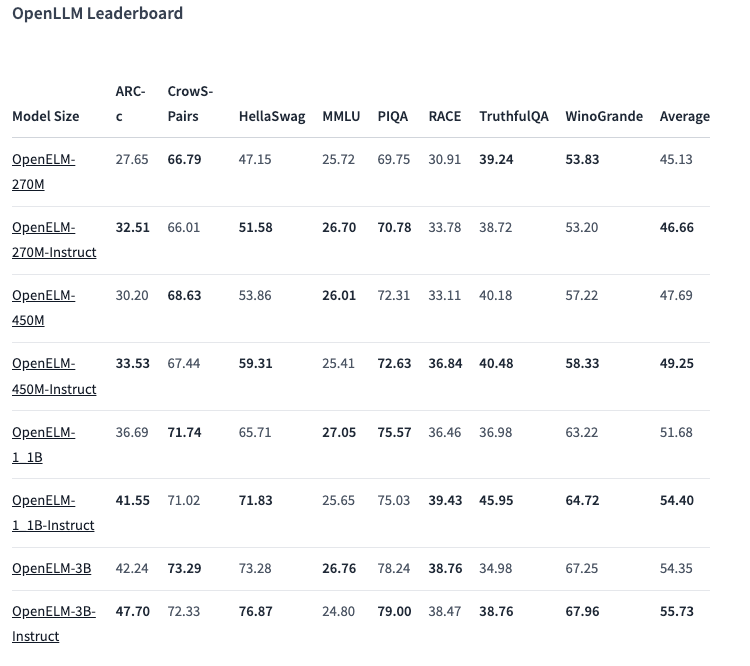

La linea OpenELM comprende otto modelli di due tipi: pre-addestrati e personalizzati in base alle istruzioni. Ogni variante è disponibile con 270 milioni, 450 milioni, 1,1 miliardi e 3 miliardi di parametri.

I modelli sono stati pre-addestrati su set di dati pubblici di 1,8 trilioni di token provenienti da siti come Reddit, Wikipedia, arXiv.org e altri.

Grazie alle ottimizzazioni, OpenELMs può funzionare su normali computer portatili e persino su alcuni smartphone. I test sono stati condotti su PC con Intel i9 e RTX 4090, nonché su MacBook Pro M2 Max.

Secondo Apple, i modelli mostrano buone prestazioni. Si distingue in particolare la variante con istruzioni da 450 milioni di parametri. E OpenELM-1.1B ha superato la sua controparte GPT OLMo del 2,36%, pur richiedendo la metà dei token per il pre-training.

Nel benchmark ARC-C, progettato per testare le conoscenze e le capacità di ragionamento, la variante OpenELM-3B pre-addestrata ha mostrato un'accuratezza del 42,24%. Al contrario, ha ottenuto un punteggio del 26,76% e del 73,28% rispettivamente su MMLU e HellaSwag.

L'azienda ha pubblicato il codice sorgente di OpenELM su Hugging Face con una licenza aperta, comprese le versioni addestrate, i benchmark e le istruzioni del modello.

Tuttavia, Apple avverte che gli OpenELM possono produrre risposte errate, dannose o inappropriate a causa della mancanza di garanzie di sicurezza.

Fonte: VentureBeat