Apple har lansert kompakte OpenELM-språkmodeller som kan kjøres på gadgets

Mohamed M/Unsplash

Apple har avduket lette OpenELM-språkmodeller som kan kjøres lokalt på enheter uten skytilkobling.

Dette er hva vi vet

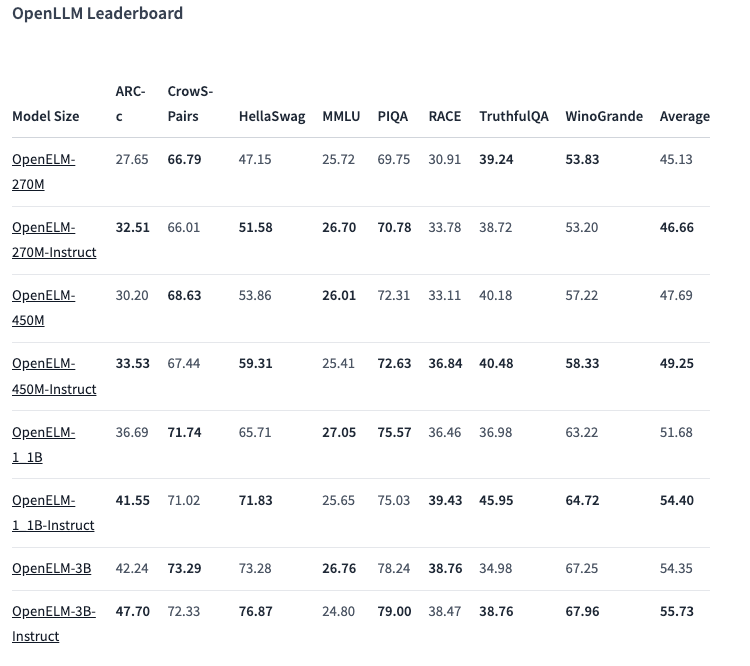

Det finnes åtte modeller av to typer i OpenELM-serien - forhåndstrenet og tilpasset etter instruksjon. Hver variant er tilgjengelig med 270 millioner, 450 millioner, 1,1 milliarder og 3 milliarder parametere.

Modellene ble forhåndstrenet på offentlige datasett med 1,8 billioner tokens fra nettsteder som Reddit, Wikipedia, arXiv.org og andre.

Takket være optimaliseringer kan OpenELMs fungere på vanlige bærbare datamaskiner og til og med på enkelte smarttelefoner. Testene ble utført på PC-er med Intel i9 og RTX 4090, samt MacBook Pro M2 Max.

Ifølge Apple viser modellene god ytelse. 450 millioner parametervarianten med instruksjoner skiller seg spesielt ut. Og OpenELM-1.1B presterte 2,36 % bedre enn sin GPT-motpart OLMo, samtidig som den krevde halvparten så mange tokens for forhåndstrening

I ARC-C-referansen, som er utformet for å teste kunnskap og resonneringsevner, oppnådde den forhåndstrente OpenELM-3B-varianten en nøyaktighet på 42,24 %. Til sammenligning fikk den 26,76 % og 73,28 % på henholdsvis MMLU og HellaSwag.

Selskapet har publisert OpenELM-kildekoden på Hugging Face under en åpen lisens, inkludert trente versjoner, benchmarks og modellinstruksjoner.

Apple advarer imidlertid om at OpenELM kan gi feilaktige, skadelige eller upassende svar på grunn av manglende sikkerhetstiltak.

kilde: VentureBeat