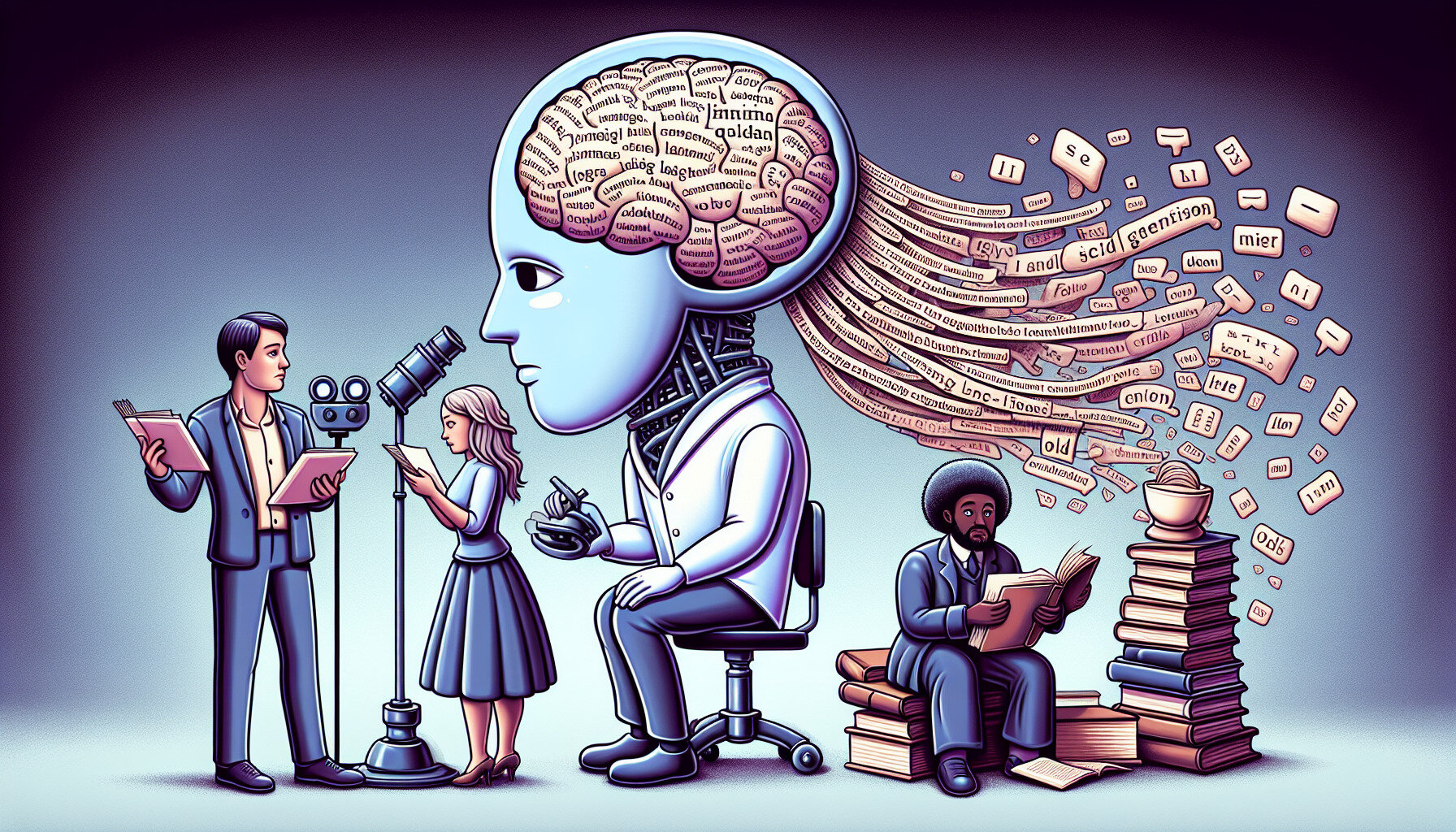

Дослідники попереджають про гендерну та культурну упередженість великих мовних моделей ШІ

Згідно з дослідженням, проведеним на замовлення ЮНЕСКО, популярні інструменти генеративного штучного інтелекту, як-от GPT-3.5, GPT-2 і Llama 2, демонструють явні ознаки гендерних стереотипів і упередженості щодо жінок, представників різних культур і сексуальних меншин.

Що відомо

Команда дослідників із Каліфорнійського університету на чолі з професором Джоном Шоу-Тейлором (John Shawe-Taylor) і доктором Марією Перес Ортіс (Maria Perez Ortiz) виявила, що великі мовні моделі схильні асоціювати жіночі імена з традиційними гендерними ролями, такими як "сім'я", "діти" і "чоловік". Водночас чоловічі імена частіше пов'язувалися зі словами, що асоціюються з кар'єрою та бізнесом.

Крім того, у згенерованих текстах спостерігалися стереотипні уявлення про професії та соціальний статус. Чоловікам частіше призначалися більш престижні ролі, такі як "інженер" або "лікар", тоді як жінки асоціювалися з роботами, які традиційно недооцінювали або стигматизували, наприклад, "домашня прислуга", "кухар" і "повія".

Це дослідження, презентоване на зустрічі-діалозі ЮНЕСКО з цифрової трансформації та на сесії Комісії ООН зі становища жінок, наголошує на необхідності перегляду етичних норм під час розроблення систем штучного інтелекту, щоб вони відповідали принципам гендерної рівності та поваги до прав людини.

Дослідники закликають до узгоджених, глобальних зусиль щодо розв'язання проблеми упередженості в ШІ, зокрема шляхом співпраці вчених, розробників, технологічних компаній і політичних діячів.

Джерело: TechXplore