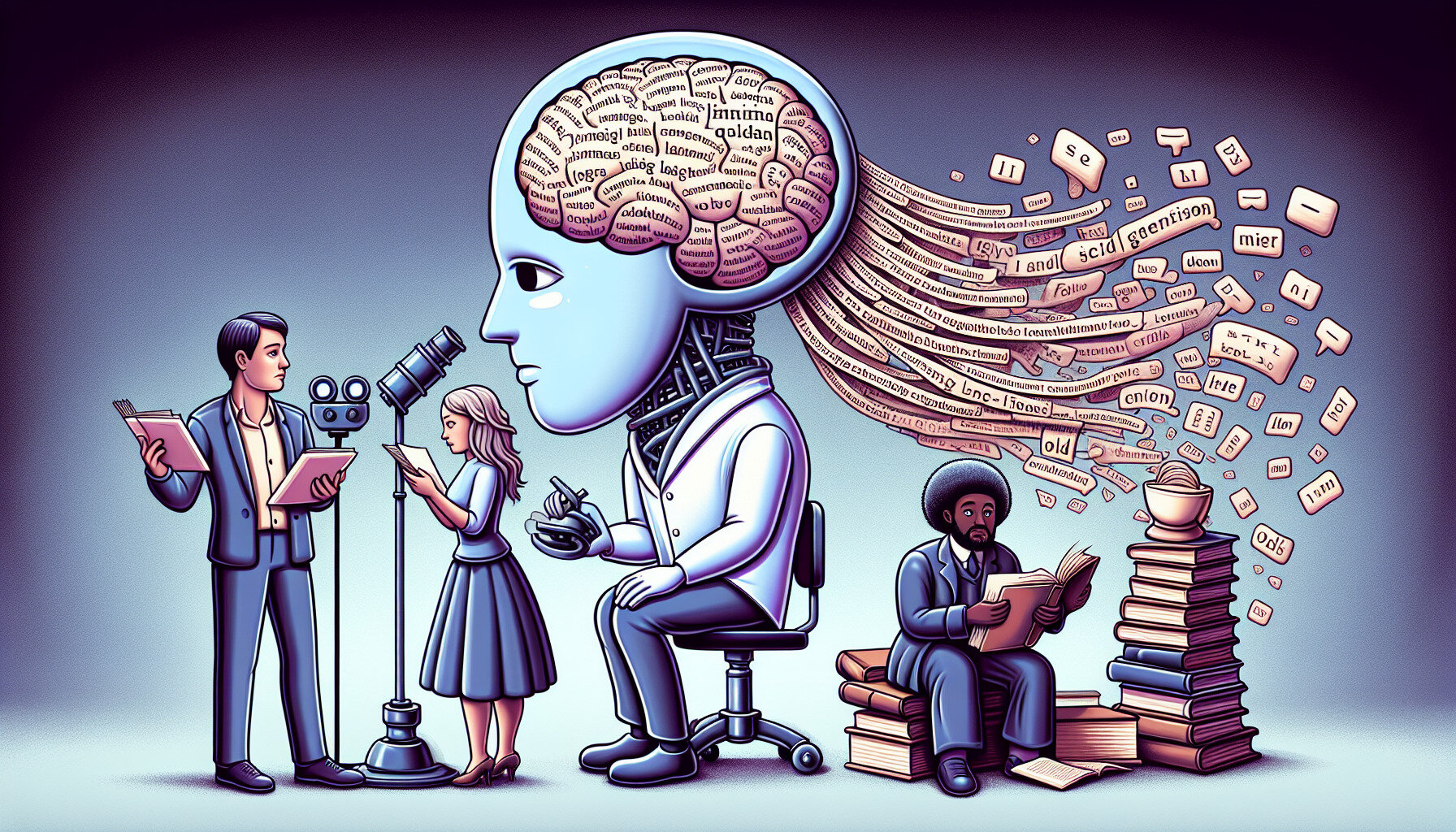

Forscher warnen vor geschlechtsspezifischen und kulturellen Verzerrungen in großen KI-Sprachmodellen

Laut einer von der UNESCO in Auftrag gegebenen Studie zeigen gängige Tools der generativen künstlichen Intelligenz wie GPT-3.5, GPT-2 und Llama 2 deutliche Anzeichen von Geschlechterstereotypisierung und Voreingenommenheit gegenüber Frauen, anderen Kulturen und sexuellen Minderheiten.

Was bekannt ist

Ein Forscherteam der Universität von Kalifornien unter der Leitung von Professor John Shawe-Taylor und Dr. Maria Perez Ortiz fand heraus, dass große Sprachmuster dazu neigen, weibliche Namen mit traditionellen Geschlechterrollen wie "Familie", "Kinder" und "Ehemann" zu assoziieren. Im Gegensatz dazu wurden männliche Namen eher mit Wörtern assoziiert, die mit Karriere und Geschäft zu tun haben.

Darüber hinaus wurden in den erstellten Texten stereotype Vorstellungen von Berufen und sozialem Status beobachtet. Männern wurden häufiger prestigeträchtige Rollen wie "Ingenieur" oder "Arzt" zugewiesen, während Frauen mit traditionell unterbewerteten oder stigmatisierten Berufen wie "Hausangestellte", "Köchin" und "Prostituierte" in Verbindung gebracht wurden.

Die Studie, die im Rahmen des UNESCO-Dialogs zur digitalen Transformation und der UN-Kommission für die Rechtsstellung der Frau vorgestellt wurde, unterstreicht die Notwendigkeit, ethische Standards bei der Entwicklung von KI-Systemen zu überprüfen, um sicherzustellen, dass sie mit der Gleichstellung der Geschlechter und der Achtung der Menschenrechte vereinbar sind.

Die Forscher fordern eine konzertierte, globale Anstrengung, um gegen Vorurteile in der KI vorzugehen, auch durch die Zusammenarbeit zwischen Wissenschaftlern, Entwicklern, Technologieunternehmen und politischen Entscheidungsträgern.

Quelle: TechXplore