Apple hat kompakte OpenELM-Sprachmodelle zur Ausführung auf Gadgets freigegeben

Mohamed M/Unsplash

Apple hat leichtgewichtige OpenELM-Sprachmodelle vorgestellt, die lokal auf Geräten ohne Cloud-Verbindung ausgeführt werden können.

Was bekannt ist

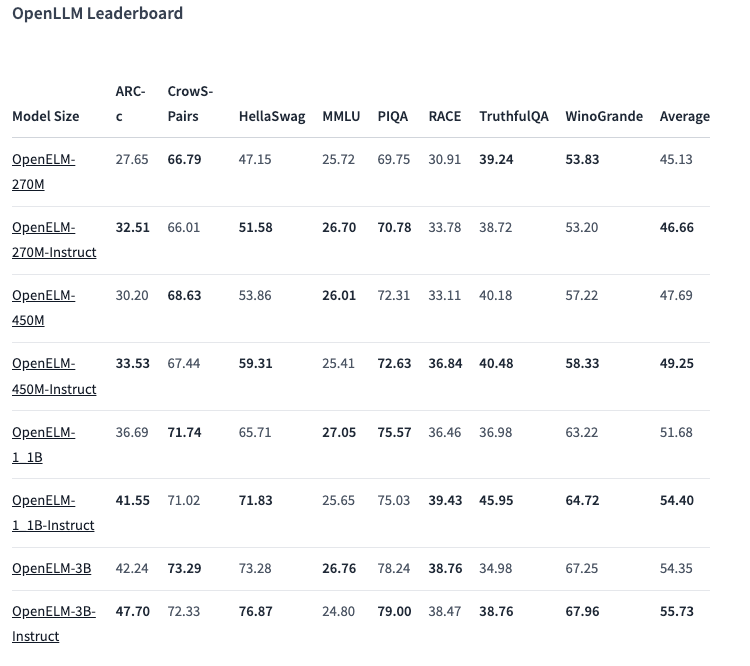

Die OpenELM-Reihe umfasst acht Modelle zweier Typen - vortrainierte und durch Anweisungen angepasste. Jede Variante ist mit 270 Millionen, 450 Millionen, 1,1 Milliarden und 3 Milliarden Parametern verfügbar.

Die Modelle wurden auf öffentlichen Datensätzen mit 1,8 Billionen Token von Websites wie Reddit, Wikipedia, arXiv.org und anderen vortrainiert.

Dank Optimierungen können die OpenELMs auf normalen Laptops und sogar auf einigen Smartphones funktionieren. Die Tests wurden auf PCs mit Intel i9 und RTX 4090 sowie auf dem MacBook Pro M2 Max durchgeführt.

Nach Angaben von Apple zeigen die Modelle eine gute Leistung. Die 450-Millionen-Parameter-Variante mit Anweisungen sticht besonders hervor. Und OpenELM-1.1B übertraf sein GPT-Pendant OLMo um 2,36%, während es nur halb so viele Token für das Pre-Training benötigte.

Im ARC-C-Benchmark, der Wissen und logisches Denken testet, zeigte die vortrainierte OpenELM-3B-Variante eine Genauigkeit von 42,24 %. Im Gegensatz dazu erreichte sie bei MMLU und HellaSwag 26,76 % bzw. 73,28 %.

Das Unternehmen hat den OpenELM-Quellcode auf Hugging Face unter einer offenen Lizenz veröffentlicht, einschließlich trainierter Versionen, Benchmarks und Modellanweisungen.

Apple warnt jedoch, dass OpenELMs aufgrund fehlender Sicherheitsvorkehrungen falsche, schädliche oder unangemessene Antworten liefern können.

Quelle: VentureBeat