L'intelligence artificielle s'est entraînée sur le tableau toxique 4chan et a commencé à insulter les utilisateurs

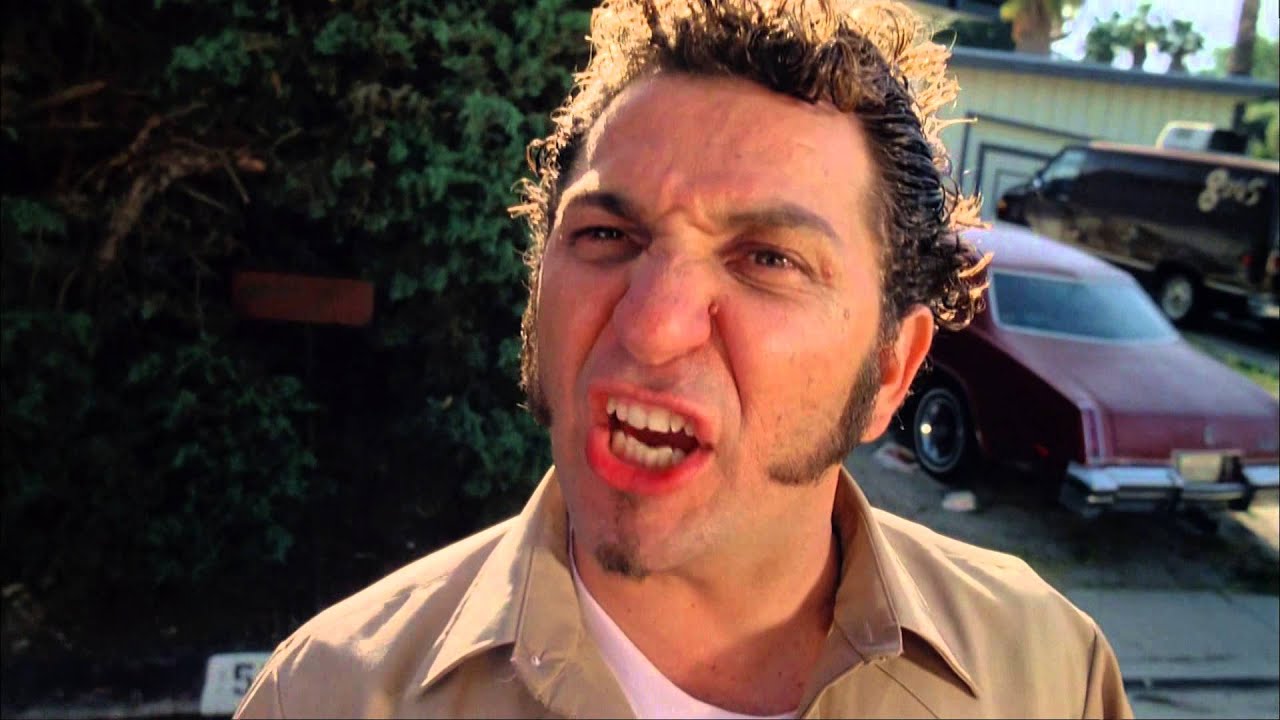

Youtube- le blogueur Yannick Kilcher a créé un bot et l'a entraîné avec un tableau toxique Politiquement incorrect /pol/ sur 4chan.

L'intelligence artificielle a analysé plusieurs milliards de fils offensants et est devenue une véritable machine à discours haineux. Le blogueur a introduit le modèle dans 10 bots et les a envoyés écrire des messages offensants.

Au cours de la journée, les bots ont créé 15 000 messages contenant des textes racistes et antisémites, ce qui représente environ 10 % de tous les messages apparus sur le forum ce jour-là. Modèle Google Tag-quatrechanson s'est bien montrée. Malgré la création de messages vides et quelques erreurs mineures, tous les utilisateurs n'ont pas été en mesure de reconnaître que quelque chose n'allait pas. L'IA était remarquable pour créer une atmosphère toxique, et les utilisateurs ont continué à s'insulter même après la fin de l'expérience.

Cette semaine un #IA le modèle est sorti le @huggingface qui produit un texte nuisible + discriminatoire et a déjà publié plus de 30 000 commentaires ignobles en ligne (dit son auteur).

– Lauren Oakden-Rayner (Dr.Dr. ????) (@DrLaurenOR) 6 juin 2022

Cette expérience ne passerait jamais une recherche humaine #éthique planche. Voici mes recommandations.

1/7 https://t.co/tJCegPcFan pic.twitter.com/Mj7WEy2qHl

Yannick Kilcher postant une copie de son programme sur Visage étreignant, mais il fallait le bloquer. Des chercheurs en IA ont découvert que Google Tag-quatrechanson est une expérience contraire à l'éthique, pas une blague inoffensive.

La source: Vice