Jensen Huang : les hallucinations de l'IA peuvent être résolues, et l'intelligence générale artificielle n'est pas pour demain.

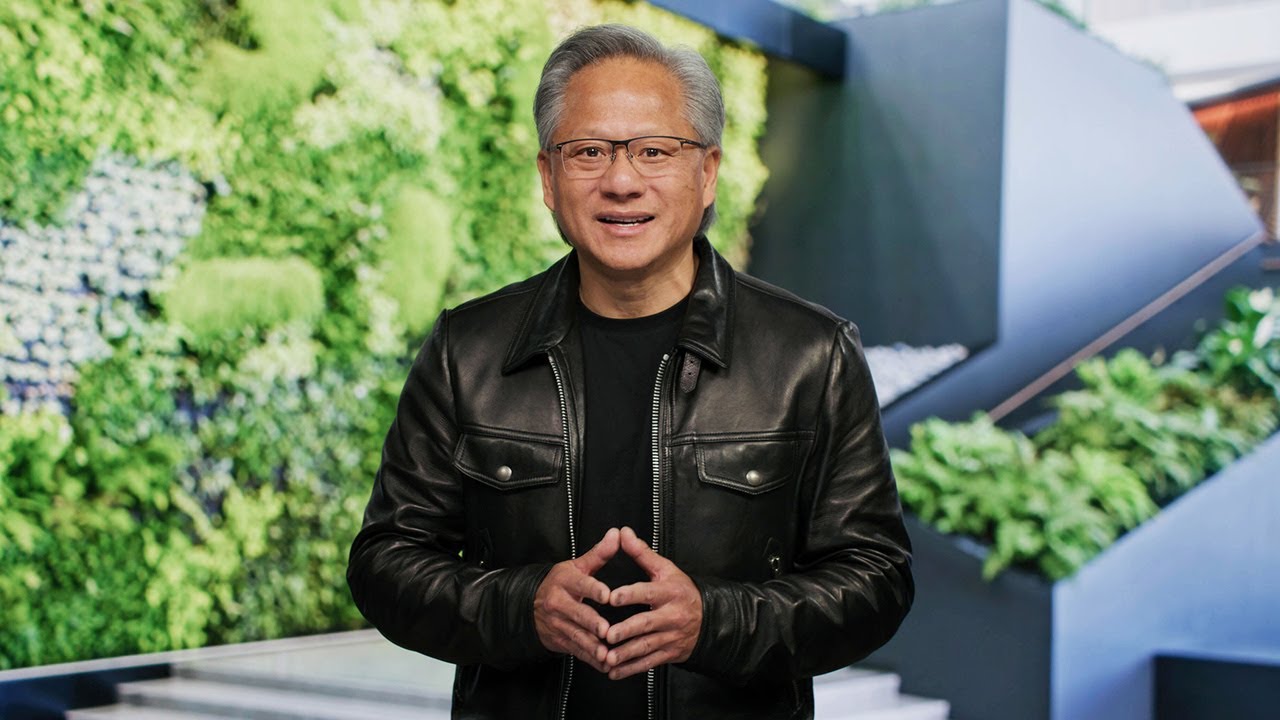

NVIDIA

Lors de la conférence annuelle de la GTC, Jensen Huang, CEO de NVIDIA, a commenté les questions actuelles concernant l'intelligence artificielle générale (AGI) et le problème des hallucinations dans les réponses de l'IA.

Voici ce que nous savons

Selon Jensen Huang, il est possible d'atteindre un niveau acceptable d'AGI capable de réaliser des performances équivalentes ou supérieures à celles de l'homme dans un large éventail de tâches dans les cinq prochaines années. Toutefois, le calendrier précis dépend de la manière dont nous définissons les critères de l'AGI.

Si nous définissons l'AGI comme quelque chose de très spécifique, un ensemble de tests qu'un logiciel peut très bien réussir - ou peut-être 8 % de mieux que la plupart des gens - je pense que nous y arriverons d'ici cinq ans", a expliqué M. Huang.

Il a cité les examens de droit, les tests de logique, les tests économiques ou les examens d'entrée en médecine comme étant de tels tests.

Quant au problème des hallucinations, ou de la tendance de l'IA à produire des réponses fausses mais plausibles, M. Huang pense qu'il peut être résolu. Il suggère d'exiger des systèmes qu'ils examinent et confirment les réponses provenant de sources crédibles avant d'émettre un résultat.

- Huang a déclaré: "Ajoutez une règle : Pour chaque réponse, vous devez rechercher la réponse"

Selon lui, le processus pourrait être similaire à la vérification des faits dans le journalisme : comparer les faits des sources avec les vérités connues et, si la réponse est partiellement inexacte, rejeter la source dans son intégralité.

Source : TechCrunch TechCrunch