Opera met à jour son navigateur pour ajouter la prise en charge des modèles d'IA locaux

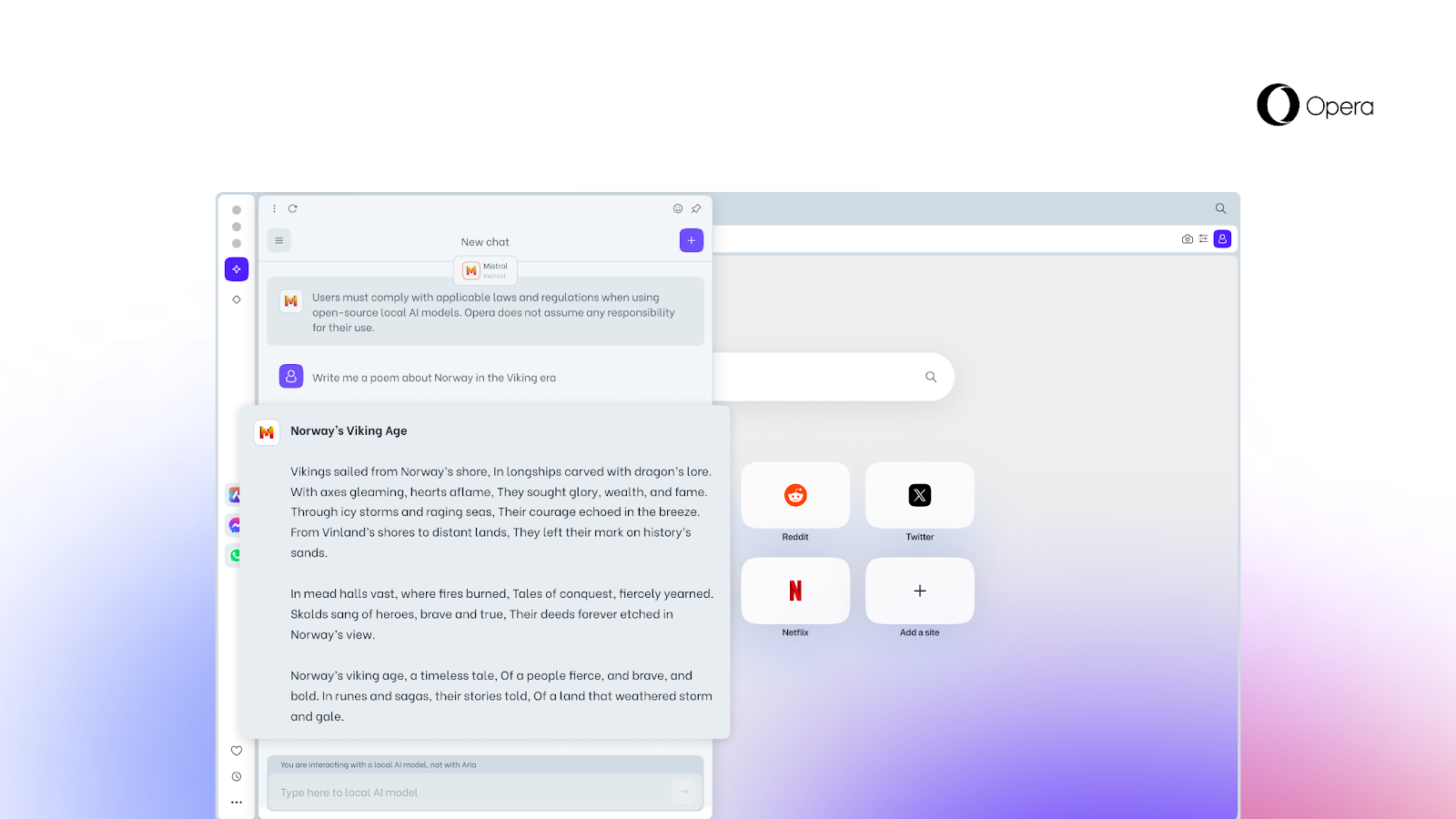

Opera, une entreprise qui investit activement dans l'intelligence artificielle (IA), a dévoilé une nouvelle fonctionnalité qui permet aux utilisateurs d'accéder à des modèles d'IA locaux directement à partir du navigateur.

Voici ce que nous savons

Cette option, qu'aucun autre navigateur n'offre encore, est rendue possible par l'ajout d'une prise en charge expérimentale de 150 variantes de grands modèles linguistiques locaux (LLM) issus d'une cinquantaine de familles de modèles.

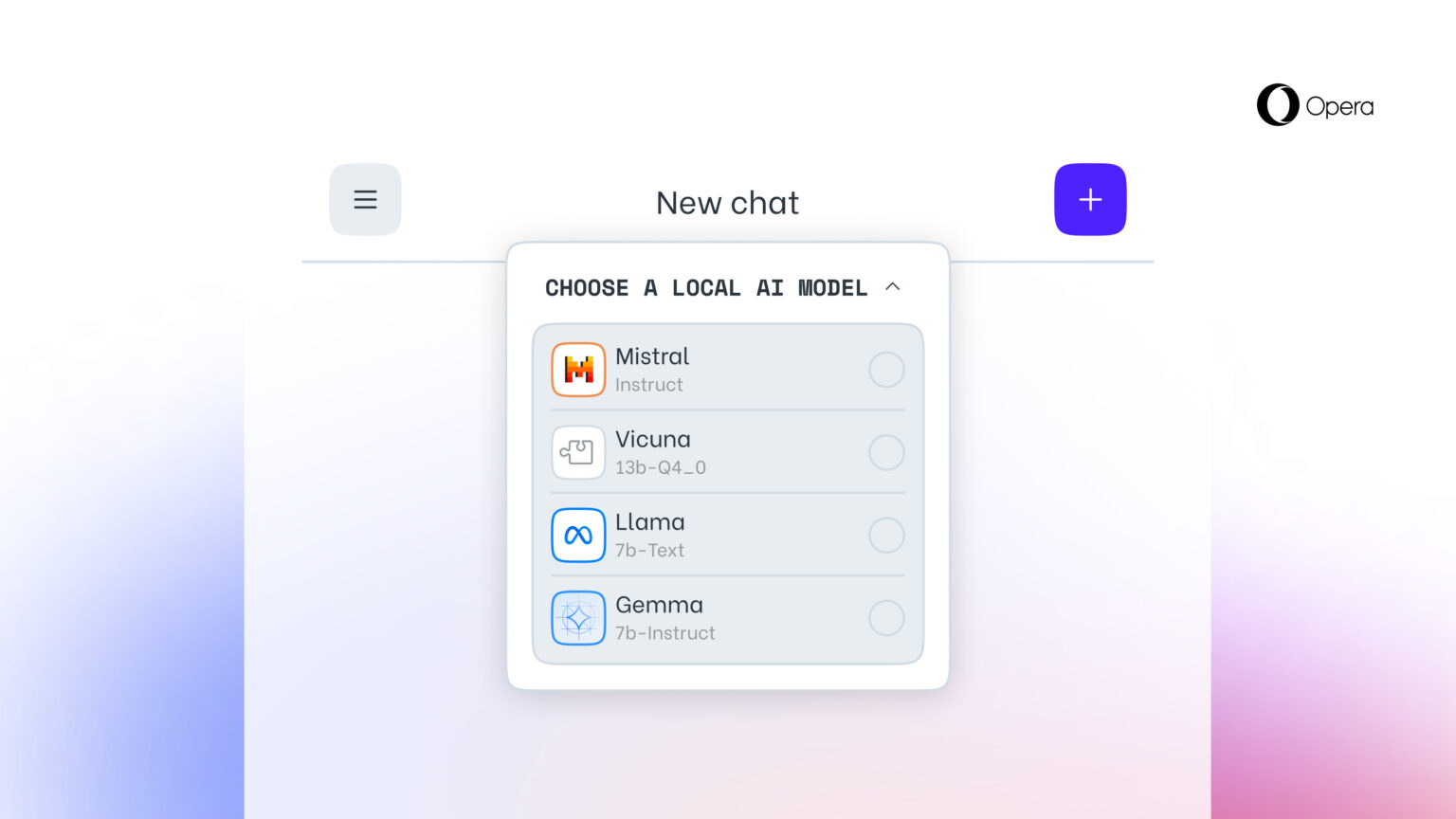

Les modèles d'IA locaux sont un ajout au service en ligne Aria AI d'Opera, qui est également disponible dans le navigateur Opera sur iOS et Android. Les LLM locaux pris en charge comprennent des modèles tels que Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) et bien d'autres.

Cette nouvelle fonctionnalité est particulièrement importante pour ceux qui souhaitent préserver leur vie privée lorsqu'ils naviguent sur le web. La possibilité d'accéder aux LLM locaux à partir d'Opera signifie que les données des utilisateurs sont stockées localement sur leur appareil, ce qui leur permet d'utiliser l'IA générative sans avoir à envoyer des informations à un serveur.

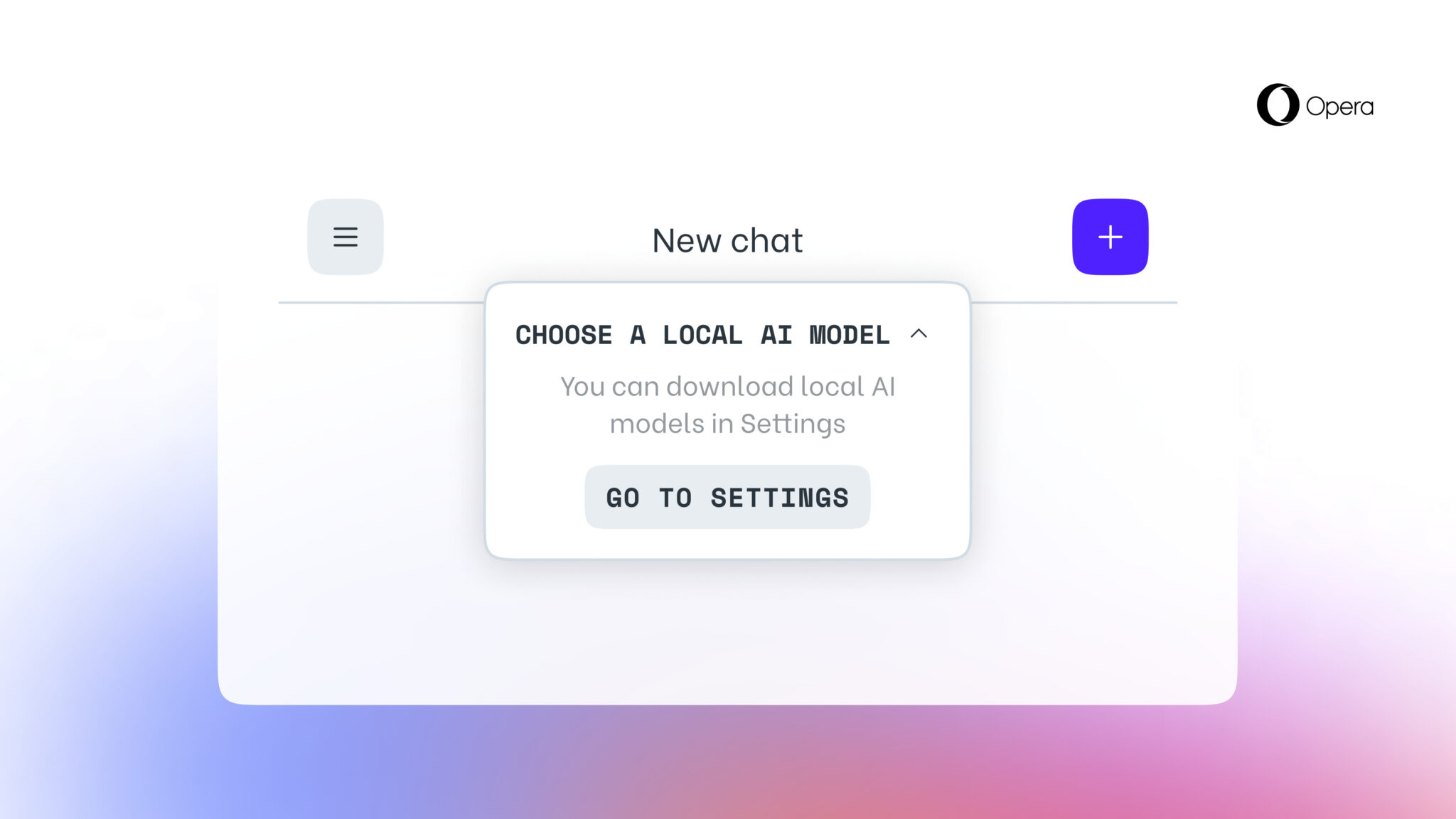

À partir d'aujourd'hui, la nouvelle fonctionnalité est disponible pour les utilisateurs d'Opera One Developer, bien que vous deviez passer à la dernière version d'Opera Developer et suivre le guide étape par étape pour l'activer.

Il convient de rappeler qu'une fois que vous aurez sélectionné un LLM spécifique, celui-ci sera téléchargé sur votre appareil. Il est également important de noter qu'un LLM local nécessite généralement entre 2 et 10 Go d'espace disque pour chaque option. Une fois téléchargé sur votre appareil, le nouveau LLM sera utilisé à la place d'Aria, l'IA intégrée du navigateur Opera.

Source : Opera