Apple a publié des modèles de langage OpenELM compacts pour les gadgets.

Mohamed M/Unsplash

Apple a dévoilé des modèles de langage OpenELM légers qui peuvent être exécutés localement sur des appareils sans connexion au cloud.

Voici ce que nous savons

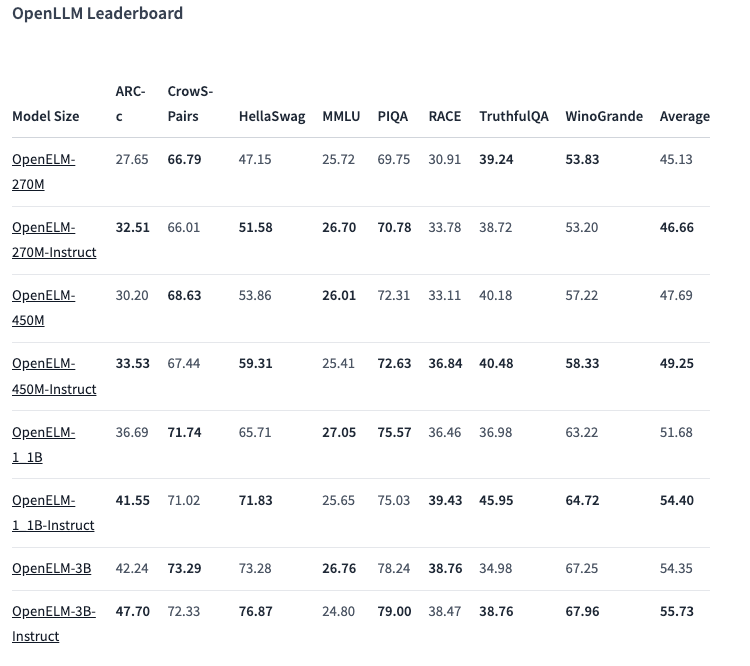

La gamme OpenELM comprend huit modèles de deux types : pré-entraînés et personnalisés par instruction. Chaque variante est disponible avec 270 millions, 450 millions, 1,1 milliard et 3 milliards de paramètres.

Les modèles ont été pré-entraînés sur des ensembles de données publiques de 1,8 trillion de jetons provenant de sites tels que Reddit, Wikipedia, arXiv.org et d'autres.

Grâce à des optimisations, OpenELMs peut fonctionner sur des ordinateurs portables ordinaires et même sur certains smartphones. Les tests ont été effectués sur des PC équipés d'Intel i9 et de RTX 4090, ainsi que sur des MacBook Pro M2 Max.

Selon Apple, ces modèles présentent de bonnes performances. La variante à 450 millions de paramètres avec instructions se distingue particulièrement. Et OpenELM-1.1B a surpassé son homologue GPT OLMo de 2,36 %, tout en nécessitant deux fois moins de jetons pour le pré-entraînement

Dans le test de référence ARC-C, conçu pour tester les connaissances et les capacités de raisonnement, la variante pré-entraînée d'OpenELM-3B a obtenu une précision de 42,24 %. En revanche, elle a obtenu 26,76 % et 73,28 % sur MMLU et HellaSwag, respectivement.

La société a publié le code source d'OpenELM sur Hugging Face sous licence ouverte, y compris les versions entraînées, les points de référence et les instructions du modèle.

Cependant, Apple prévient que les OpenELM peuvent produire des réponses incorrectes, nuisibles ou inappropriées en raison d'un manque de garanties de sécurité.

Source : VentureBeat