Microsoft a présenté Maia 200 — sa propre puce IA pour dépendre moins de NVIDIA

La société Microsoft a officiellement annoncé Maia 200 — un nouveau processeur spécialisé pour les calculs IA, principalement axé sur l'inférence, c'est-à-dire le lancement de modèles déjà formés. La puce est le successeur de Maia 100, lancée en 2023, et reflète la stratégie de Microsoft pour réduire les coûts de l'infrastructure IA et diminuer la dépendance aux équipements NVIDIA.

Ce qui est connu

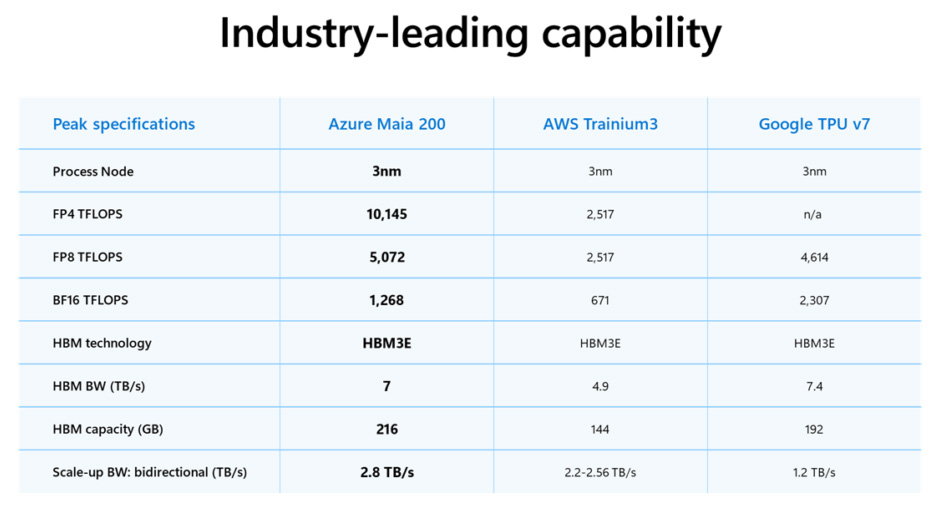

Maia 200 contient plus de 100 milliards de transistors et est fabriqué selon le procédé technologique 3 nm de TSMC. Selon Microsoft, l'accélérateur offre plus de 10 pétaflops de performance avec une précision de 4 bits (FP4) et environ 5 pétaflops en 8 bits (FP8). Ces caractéristiques permettent de lancer les plus grands modèles linguistiques modernes sur un seul nœud avec de la marge pour leur complexité croissante.

L'accent mis sur l'inférence s'explique simplement : à mesure que les services IA se développent, c'est l'exécution des modèles, et non leur apprentissage, qui devient le principal poste de dépense. Microsoft espère que Maia 200 réduira la consommation d'énergie et simplifiera le déploiement des systèmes IA dans les centres de données Microsoft Azure.

La société compare directement la nouveauté avec les alternatives des concurrents. Selon ses données, Maia 200 offre une performance FP4 trois fois plus élevée que la troisième génération d'Amazon Trainium et dépasse également les performances FP8 du Google TPU de septième génération.

En pratique, Maia 200 est déjà utilisé au sein de Microsoft — pour faire fonctionner les modèles de la division Superintelligence et les services Copilot. Parallèlement, la société ouvre l'accès au SDK pour les développeurs, les chercheurs et les laboratoires IA. Les premiers déploiements de la puce ont déjà commencé dans les centres de données aux États-Unis, et une extension à d'autres régions est prévue prochainement.

Source: Microsoft