Opera aggiorna il suo browser aggiungendo il supporto per i modelli AI locali

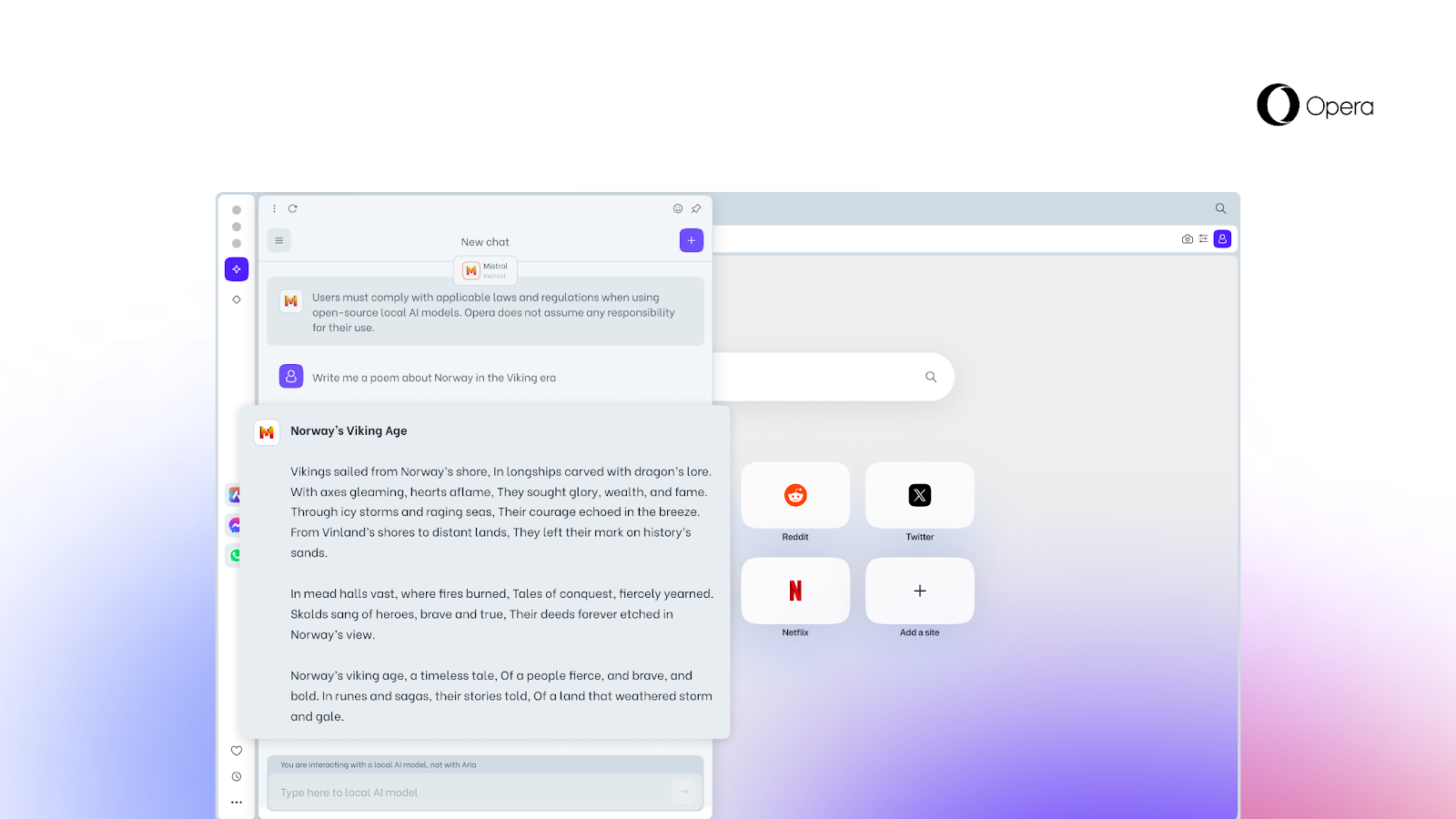

Opera, un'azienda che investe attivamente nell'intelligenza artificiale (AI), ha presentato una nuova funzione che consente agli utenti di accedere a modelli di AI locali direttamente dal browser.

Ecco cosa sappiamo

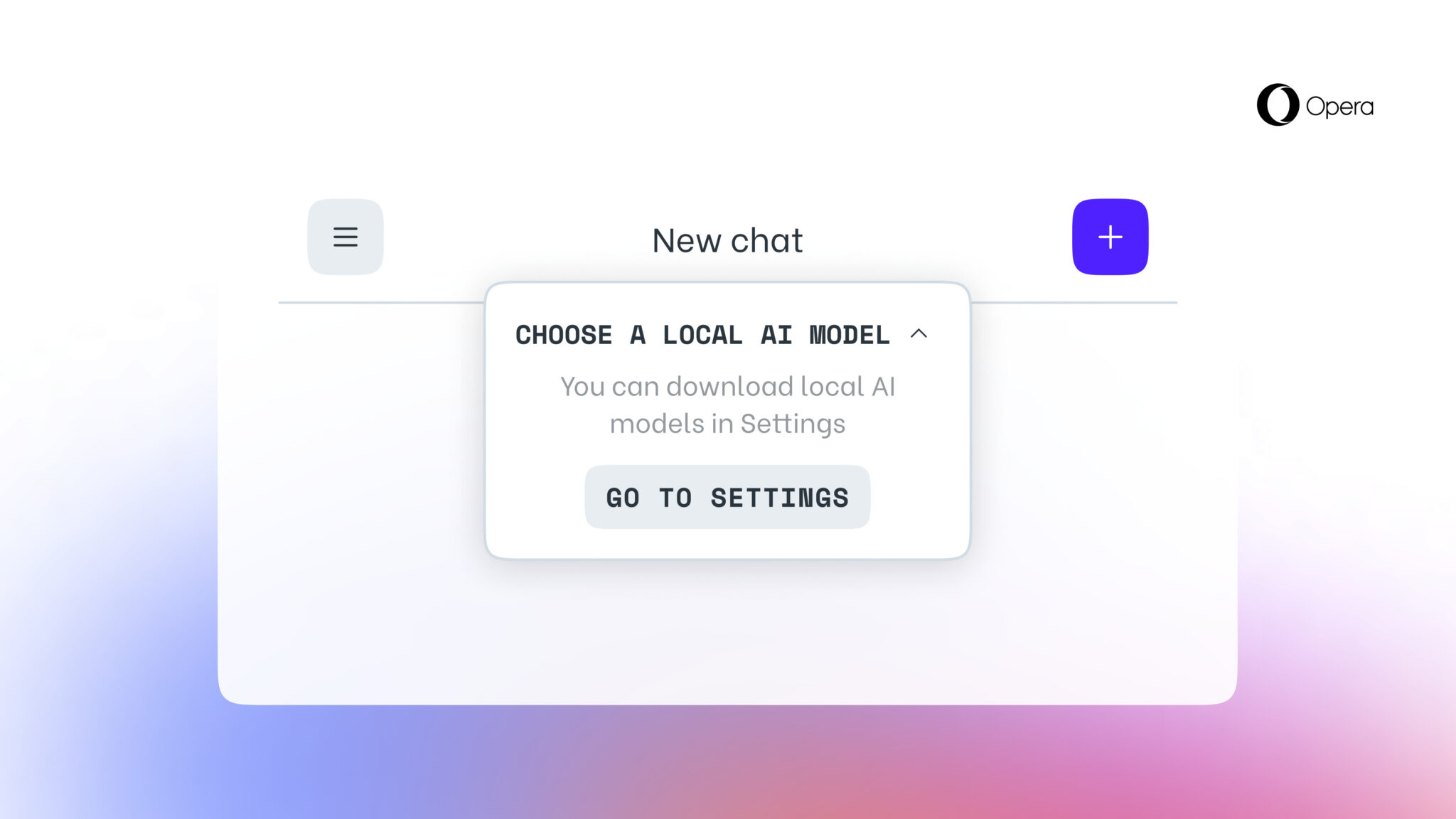

Questa opzione, che nessun altro browser ancora offre, è resa possibile dall'aggiunta di un supporto sperimentale per 150 varianti di modelli linguistici locali (LLM) di circa 50 famiglie di modelli.

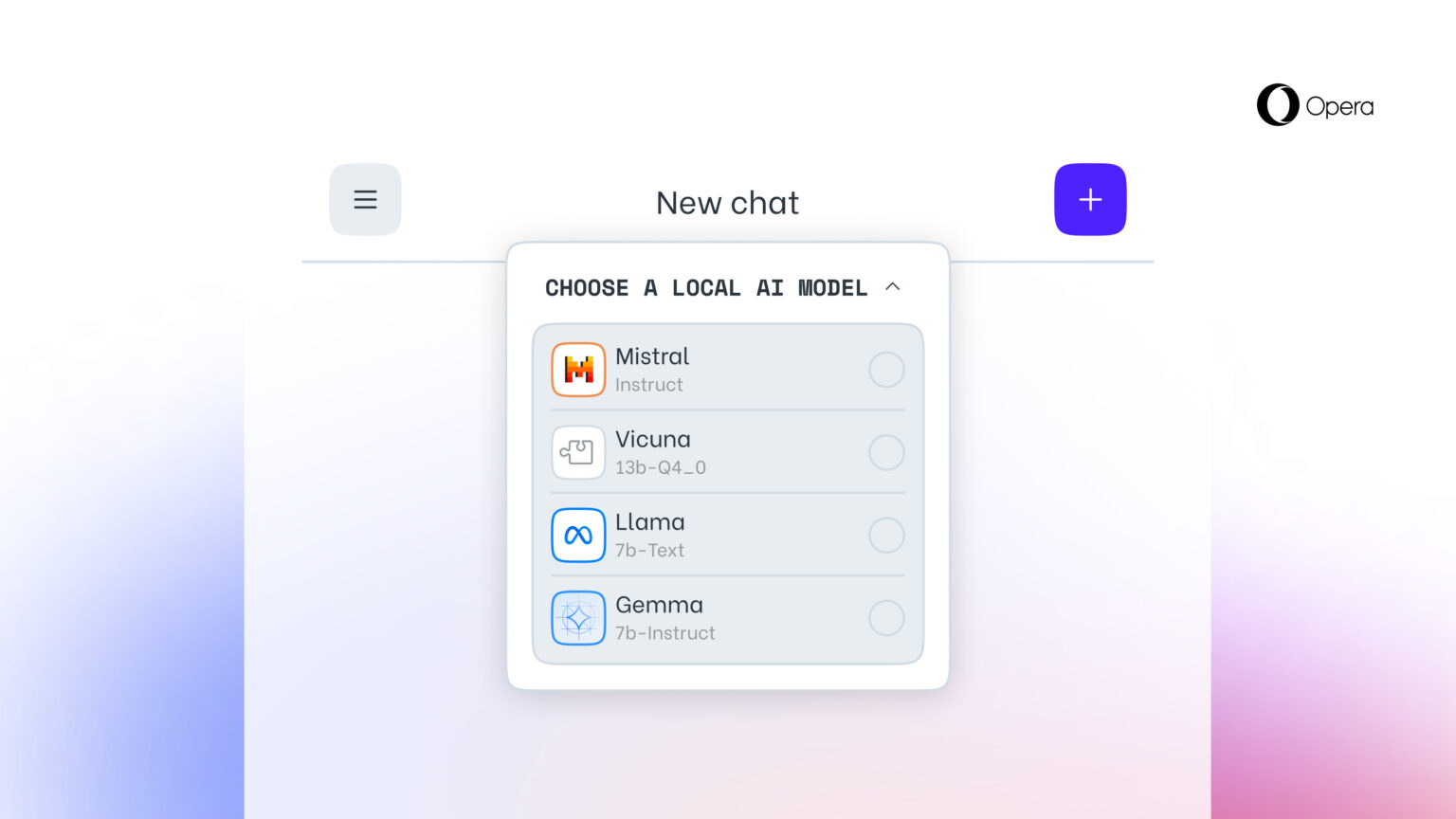

I modelli AI locali sono un'aggiunta al servizio online Aria AI di Opera, disponibile anche nel browser Opera su iOS e Android. Gli LLM locali supportati includono modelli come Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) e molti altri.

La nuova funzione è particolarmente importante per chi vuole mantenere la privacy durante la navigazione sul web. La possibilità di accedere agli LLM locali da Opera significa che i dati degli utenti sono memorizzati localmente sul loro dispositivo, consentendo loro di utilizzare l'IA generativa senza dover inviare informazioni a un server.

A partire da oggi, la nuova funzione è disponibile per gli utenti di Opera One Developer, anche se per attivarla è necessario aggiornare all'ultima versione di Opera Developer e seguire la guida passo passo.

Vale la pena ricordare che una volta selezionato un LLM specifico, questo verrà scaricato sul dispositivo. È inoltre importante notare che un LLM locale richiede in genere tra i 2 GB e i 10 GB di spazio su disco per ogni opzione. Una volta scaricato sul dispositivo, il nuovo LLM verrà utilizzato al posto di Aria, l'AI integrata del browser Opera.

Fonte: Opera