Новый инструмент Nightshade позволяет художникам скрыто портить данные для обучения ИИ

Чикагский университет

Команда Чикагского университета разработала инструмент Nightshade, который дает художникам возможность добавлять в работы невидимые пиксели, портящие обучающие данные для ИИ.

Что известно

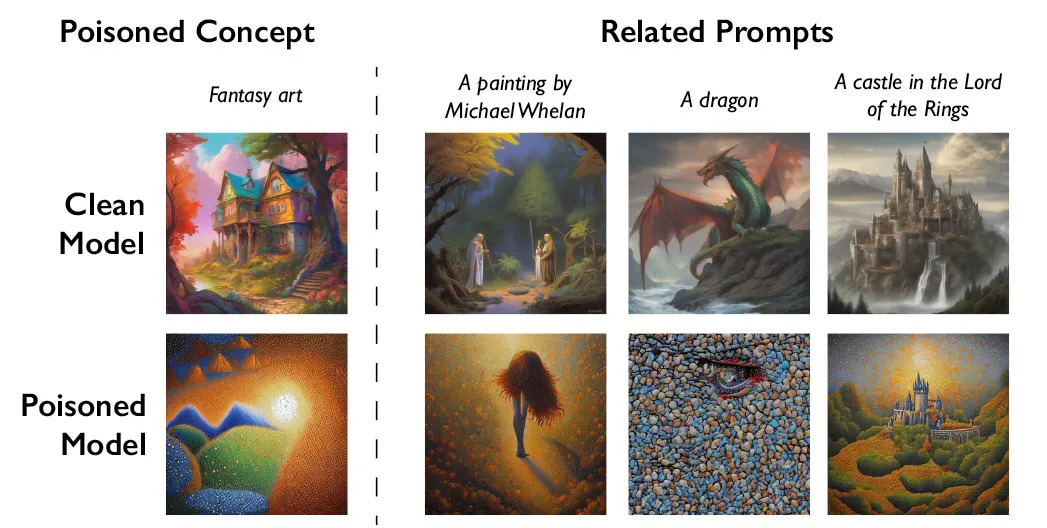

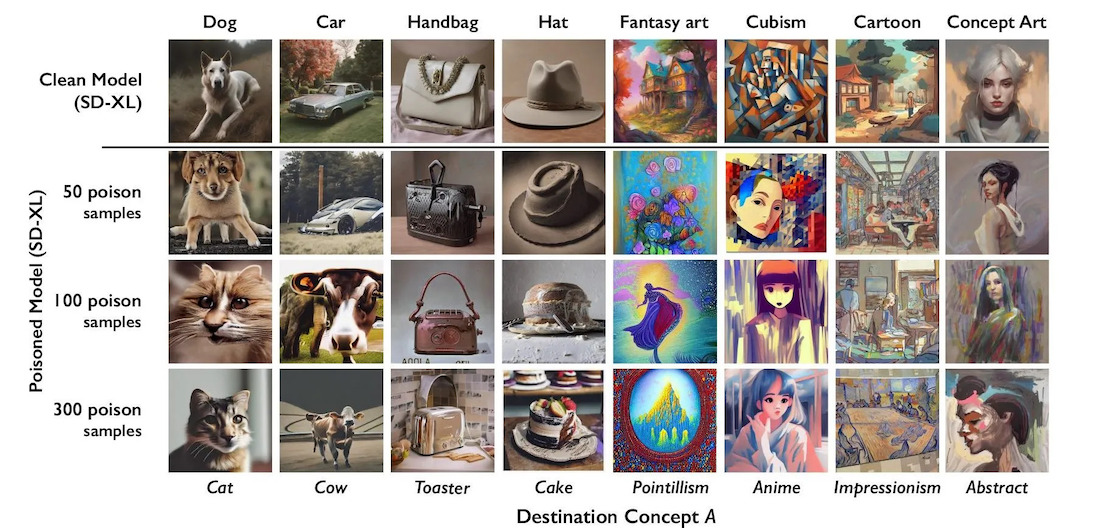

Принцип работы Nightshade состоит в том, что он внедряет своего рода "яд" в обучающие данные. Это заставляет ИИ неправильно интерпретировать запросы пользователей и создавать искаженный контент. Например, система может выдавать изображение кошки вместо собаки по запросу.

По замыслу разработчиков, такой подход должен стимулировать компании вроде OpenAI, активно использующие данные художников для обучения ИИ, запрашивать разрешение на это и выплачивать компенсации. Чтобы удалить испорченные Nightshade данные из обучающей выборки, им придется вручную отыскать каждый такой фрагмент, что является крайне трудозатратным.

В настоящее время инструмент проходит экспертную оценку и тестирование. Разработчики проверили его работу на популярной модели Stable Diffusion, а также на собственной экспериментальной модели ИИ.

По их словам, Nightshade не является панацеей, и некоторые могут воспользоваться им в корыстных целях. Но чтобы нанести серьезный ущерб обучению ИИ, злоумышленникам потребуется добавить искажения в тысячи произведений искусства.

Nightshade стал вторым подобным инструментом после Glaze, выпущенного той же командой в августе 2022 года. Glaze также незаметно для человека вносит изменения в изображения, защищая авторские права художников.

Источник: MIT Technology Review

Подписывайтесь на наш нескучный канал в Telegram, чтобы ничего не пропустить.